Ahorra un 25 % (o incluso más) en tus costes de Kafka | Acepta el reto del ahorro con Kafka de Confluent

Pipelines de datos en streaming

Las pipelines de datos en streaming permiten la ingesta, el procesamiento y el movimiento continuos de sus fuentes a su destino en el momento en el que se generan los datos en tiempo real. Conocida también como streaming ETL y flujo de datos en tiempo real, esta tecnología se utiliza en innumerables sectores para convertir las bases de datos en feeds en directo para la ingesta y el procesamiento de streams de forma continua con el fin de acelerar la entrega de datos, la toma de decisiones en tiempo real y el análisis.

Creada por los fundadores de Apache Kafka, la plataforma de streaming de datos de Confluent automatiza las pipelines de datos en tiempo real con más de 120 integraciones prediseñadas además de seguridad y gobernanza integradas para innumerables casos de uso.

What Are Streaming Data Pipelines?

- Mobile banking apps

- GPS apps that recommend driving routes based on live traffic information

- Smartwatches that track steps and heart rate

- Personalized real-time recommendations in shopping or entertainment apps

- Sensors in a factory where temperatures or other conditions need to be monitored to prevent safety incidents

En tiempo real y a gran escala.

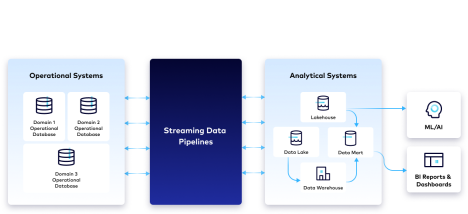

Las pipelines de datos en streaming admiten diversos formatos de datos de fuentes heterogéneas y operan a una escala de millones de eventos por segundo. Descomponen los silos de datos transmitiendo datos entre entornos, desbloqueando flujos de datos en tiempo real para una empresa y, a menudo, se utilizan para conectar dos tipos de sistemas:

- Sistemas operativos en los que los datos en diferentes formatos se almacenan en bases de datos operativas que pueden estar en las instalaciones locales o en la nube.

- Sistemas analíticos donde los datos completan un almacén de datos o un data lake y se utilizan para análisis en tiempo real, informes, paneles de BI y otras iniciativas de ciencia de datos.

¿Por qué usar pipelines de datos en streaming?

Flujos de datos en tiempo real

Al mover y transformar los datos de los sistemas fuente a los de destino a medida que se producen en tiempo real, las pipelines de datos en streaming ofrecen los datos más recientes y precisos en un formato de uso sencillo, lo que aumenta la agilidad de desarrollo y descubre información que ayuda a las organizaciones a tomar decisiones proactivas y mejor informadas. La capacidad de responder de manera inteligente a eventos en tiempo real reduce el riesgo, genera más ingresos o ahorros de costes y ofrece experiencias de cliente más personalizadas.

Procesamiento de streams en tiempo real

El procesamiento de streams tiene ventajas significativas sobre el procesamiento por lotes, especialmente en lo que respecta a la latencia de los datos. Las pipelines ETL por lotes ingieren y transforman los datos por lotes periódicos, a menudo nocturnos. Por el contrario, el procesamiento de streams permite transformar continuamente los datos en tiempo real al tiempo que se encuentran de camino a los sistemas de destino y a medida que se generan los datos. Esto minimiza la latencia y permite que los datos en streaming hagan realidad distintos casos de uso, como la detección de fraudes en tiempo real. Si quieres más información sobre los distintos tipos de procesamiento de datos, aquí te dejamos una comparativa entre el procesamiento por lotes y el procesamiento de streams.

Desarrollo ágil de pipelines

Al no tener que escribir el código de forma manual para cada pipelines de datos, las empresas deben dedicar menos tiempo al mantenimiento. De este modo, pueden centrarse en usar sus streams de datos de forma innovadora y en adaptar los datos a los cambios en las necesidades de la empresa. Al reducir la deuda técnica y requerir menos mantenimiento, los equipos acaban teniendo un uso de datos mejor gobernado por toda la empresa.

Una arquitectura en la nube escalable y con tolerancia a los fallos

El escalado automático y la elasticidad en la nube permiten a los consumers de datos en streaming centrarse en el uso de los datos, no en la gestión de la infraestructura. Dado que los eventos fluyen continuamente, la tolerancia a los fallos integrada protege a las empresas de la pérdida de datos, las oportunidades desaprovechadas y los retrasos en los tiempos de respuesta.

Cómo funcionan las pipelines de datos en streaming

Las pipelines de datos en streaming ejecutan continuamente una serie de pasos, como la ingesta de datos en bruto a medida que se generan, su limpieza y la personalización de los resultados para adaptarlos a las necesidades de cada empresa.

Ingesta

Los datos en tiempo real se procesan desde fuentes de datos locales y basadas en la nube (por ejemplo, aplicaciones, bases de datos, sensores IoT) en diferentes formatos.

Procesamiento de streams

La manipulación, la limpieza, la transformación y la preparación de los datos eliminan los datos inservibles de la pipeline y los preparan para su seguimiento, análisis y otros usos posteriores.

Estandarización de esquemas

Para preparar y analizar los datos en streaming, estos deben estructurarse de forma coherente en un esquema estándar; es decir, una guía que determine y comprenda cómo se organizan los datos. Seguir un esquema estándar permite que la compatibilidad de datos sea escalable y, al mismo tiempo, reduce la complejidad operativa.

Supervisión de streams

Para entender mejor los sistemas que generan eventos continuos, la mayoría de empresas aplica la observabilidad y la supervisión a los streams de eventos. La capacidad de ver lo que ocurre en los streams (por ejemplo, cuántos mensajes se producen o consumen a lo largo del tiempo) ayuda a garantizar que funcionan correctamente y entregan datos en tiempo real, sin pérdida de datos.

Broker de mensajes

Un broker de mensajes se encarga de servir y entregar datos por toda la pipeline de datos en streaming, lo que garantiza el procesamiento y el mantenimiento de la integridad y el linaje de los datos «exactly once».

Aprovisionamiento

Los datos se ponen a disposición de una variedad de destinos y consumers intermedios, que a menudo requieren acceso simultáneo a datos recientes e históricos. Para cumplir este requisito, muchas arquitecturas incluirán una combinación de almacenamiento de datos en data lakes, almacenes de datos y el propio broker de mensajes.

5 principios para crear pipelines de datos en streaming modernas

1. Streaming

Utiliza streams de datos y una plataforma de streaming para mantener repositorios de datos reutilizables en tiempo real, a nivel de eventos y de alta fidelidad dentro de la empresa, en lugar de enviar instantáneas periódicas de baja fidelidad a repositorios externos. Utiliza esquemas como el contrato de datos entre producers y consumers, lo que garantizará la compatibilidad de los datos.

2. Descentralizada

Facilita una propiedad de datos descentralizada y orientada al dominio, que permite que los equipos más cercanos a los datos creen y compartan streams de datos reutilizables. Consigue que los equipos trabajen con datos en autoservicio para que puedan publicar y suscribirse fácilmente a streams de datos en toda la empresa.

3. Declarativas

Aprovecha un lenguaje declarativo como SQL para especificar el flujo lógico de datos (es decir, de dónde provienen y a dónde van los datos) sin tener que hacerte cargo de los detalles operativos de bajo nivel: será la propia infraestructura quien se encargue de gestionar automáticamente los cambios en la escala de los datos.

4. Pensado para desarrolladores

Incorpora prácticas de desarrollo ágil y CI/CD a tus pipelines, para que tus equipos puedan crear flujos de datos modulares y reutilizables con las que desarrollar, realizar pruebas e implementar en diferentes entornos y que cambien de versión de forma independiente. Permite que distintos miembros con diferentes habilidades dentro del equipo colaboren en las pipelines utilizando herramientas que admitan tanto IDE (por las siglas en inglés de «entornos de desarrollo integrados») visuales como editores de código. Esto supone una gran diferencia frente a las herramientas ETL tradicionales, que suelen estar creadas para personas con funciones no relacionadas con el desarrollo.

5. Gobernadas

Mantén el equilibrio entre los estándares centralizados para la observabilidad, seguridad, gestión de políticas y cumplimiento normativo de los datos, al tiempo que proporcionas visibilidad, transparencia y compatibilidad de los datos con funciones de búsqueda, descubrimiento y linaje intuitivas para que los desarrolladores e ingenieros puedan innovar más rápido.

Ejemplos de casos de uso

Migración a la nube

Para migrar o modernizar las operaciones de desarrollo de aplicaciones y aprovechar las herramientas cloud-native, las pipelines de datos en streaming ayudan a conectar y sincronizar las bases de datos locales y en varias nubes en tiempo real. Los eventos se pueden procesar y enriquecer con otros streams para poner en marcha nuevas aplicaciones y reducir el mantenimiento y el coste total de propiedad de las bases de datos heredadas. No te pierdas esta demostración en la que un conector CDC de Oracle transmite los cambios de una base de datos heredada a una base de datos cloud-native como MongoDB, utilizando el procesamiento en streaming para la detección de fraudes en tiempo real.

Análisis en tiempo real

Las pipelines de datos en streaming ayudan a las empresas a obtener información valiosa al poner en marcha streams de datos desde sus sistemas locales a los almacenes de datos en la nube para realizar análisis en tiempo real, entrenar modelos de machine learning, generar informes y crear paneles de BI. Al trasladar las cargas de trabajo a la nube se consigue una mayor flexibilidad, agilidad y rentabilidad tanto en la computación como en el almacenamiento. Esta es una demostración que analiza el uso de los CDC de PostgreSQL para el streaming de datos de clientes, el procesamiento de streams para transformar los datos en tiempo real y un conector de Snowflake para el almacenamiento de datos en tiempo real y la elaboración de análisis e informes posteriores.

Optimización de SIEM

Las pipelines de datos en streaming proporcionan los datos contextualizados necesarios para ser más conscientes de la situación, ayudan a automatizar y orquestar la detección de amenazas, reducen los falsos positivos y permiten adoptar una postura proactiva frente a las amenazas y los ciberataques. Visita esta página para obtener más información sobre cómo la consolidación, categorización y enriquecimiento de datos (por ejemplo, en registros, datos de red, datos de telemetría y sensores o eventos en tiempo real) pueden dotar a los equipos de los datos adecuados en el momento oportuno para la supervisión en tiempo real y el análisis forense de la seguridad.

Acceso a datos del mainframe

Las pipelines de datos en streaming pueden desbloquear el acceso a datos fundamentales de los sistemas de registro, al permitir el acceso en tiempo real a datos de mainframe combinados con otros datos para reducir los silos y poner en marcha nuevas aplicaciones, aumentar la portabilidad de datos entre diferentes sistemas y reducir los costes de redes y MIPS. Obtén más información aquí.

Por qué elegir Confluent

Al canalizar los datos directamente de sistemas de origen a sistemas de destino, se crean conexiones punto a punto poco escalables que resultan difíciles de proteger y mantener de forma rentable. Confluent ofrece Apache Kafka de forma totalmente gestionada en una plataforma de datos en streaming que sirve como columna vertebral para la integración de datos y la creación de pipelines de datos en streaming extensibles. Con Confluent, puedes desvincular a producers y consumers de datos y abstraer el proceso de unión de sistemas heterogéneos.

Confluent ofrece más de 120 conectres source y sink preconstruidos para ayudarte a integrar y poner en marcha streams de datos entre diversos sistemas en entornos híbridos y multi-cloud. Ahorra desde 6 meses hasta incluso años de trabajo de ingeniería y reduce la carga operativa al implementar conectores totalmente gestionados que proporcionen a tus equipos datos en autoservicio donde y cuando los necesiten. Además, puedes procesar y transformar streams de datos en tiempo real con ksqlDB y garantizar la calidad de los datos y el cumplimiento de la normativa con Stream Governance. Stream Designer de Confluent es una interfaz de usuario visual sin código que te ayuda a crear, probar e implementar pipelines de datos en streaming en cuestión de minutos.