[Live Lab] Streaming 101: Hands-On with Kafka & Flink | Secure Your Spot

SERVERLOSE STREAM-VERARBEITUNG

Umgehend Echtzeit-Daten-Pipelines erstellen

Daten-Streaming und Stream-Verarbeitung kombinieren, um Daten-Pipelines zu erstellen, die Events in aktuelle, angereicherte und sofort nutzbare Datenprodukte umwandeln.

Apache Kafka® und Apache Flink® vereinen

Ein-Klick-Integration für nahtlose Stream-VerarbeitungWorkloads überall ausführen

Multicloud-Unterstützung in über 50 Regionen auf AWS, Microsoft Azure und Google CloudMit einem vertrauten Toolset entwickeln

Vorhandenes Know-how nutzen dank Unterstützung von SQL, Python und JavaDie Verwaltung separater, komplexer Open-Source-Systeme und die Wartung anfälliger Tool-Ökosysteme erzeugt unnötigen operativen Aufwand. Stattdessen könnten skalierbare und zuverlässige Echtzeit-Daten-Pipelines mit vertrauten Sprachen aufgebaut und bereitgestellt werden, um Datensilos aufzubrechen.

Confluent Cloud ist die einzige vollständig verwaltete, serverlose Plattform, die die Industriestandards für Streaming-Daten und Stream-Verarbeitung kombiniert und es ermöglicht, das Infrastrukturmanagement zu automatisieren und Pipelines von der Entwicklung bis zur Produktion zu sichern. Jetzt erfahren, welche Möglichkeiten sich ergeben, wenn der Fokus auf der Entwicklung leistungsstarker Echtzeit-Analyse- und KI-Funktionen liegt, anstatt auf der Cluster-Verwaltung.

Einführungskurs zu Apache Flink belegen

Sofort loslegen

CDC-Pipelines mit Apache Flink auf Confluent erstellen

Mehr erfahrenNahtlose Integration zwischen Kafka und Flink

Integrationsprobleme beseitigen mit einer Ein-Klick-Integration von Apache Kafka® und Apache Flink® auf Confluent, wo Daten als erstklassiges, wiederverwendbares Produkt behandelt werden.

Kafka-Topics erscheinen automatisch als abfragbare Flink-Tabellen mit Schemata, die von der Schema Registry verwaltet werden, wodurch verarbeitete Daten sofort wiederverwendbar sind.

1-Klick-Integration

Kafka-Topics und Schemas sind immer mit Flink synchronisiert

Cloud-natives Streaming

Der Cloud-native, vollständig verwaltete Standard für Apache Kafka®

Cloud-native Apache Flink®

Der Open-Source-Standard für Stream-Verarbeitung

Native Unterstützung für Schema-Management

Schema Registry bietet ein zentrales Repository zur Schema-Verwaltung und Validierung für Topic-Messagedaten

Zustandsbehaftete Streamverarbeitung vereinfachen

Die Leistungsfähigkeit von Flink nutzen, dem De-facto-Branchenstandard für die Verarbeitung komplexer, zustandsbehafteter Event-Streams.

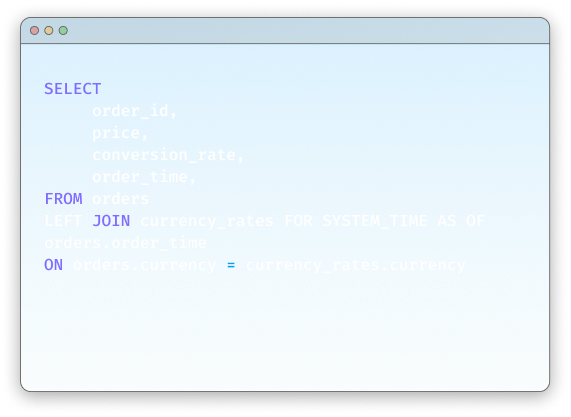

Mit branchenüblichen Sprachen wie ANSI SQL, Python oder Java, können komplexe Event-Verarbeitung, Echtzeitaggregationen, und zustandsbehaftete Transformationen durchgeführt werden, mit integrierter Fehlertoleranz, Exactly-Once-Semantik und Standard-Watermarking-Strategien.

Exactly-Once vereinfacht

Exactly-Once-Processing mühelos gewährleisten mit Confluent Cloud

Mit ANSI SQL entwickeln

Stream-Processing-Pipelines mit vertrauter SQL aufbauen

Mit Python entwickeln

Stream-Processing-Pipelines mühelos mit Python aufbauen

Mit Java entwickeln

Streaming-Anwendungen mit Java erstellen

Schneller Mehrwert liefern, dank einer vollständig verwalteten Plattform

Voll auf die Entwicklung von Datenprodukten konzentrieren statt Infrastruktur zu verwalten – dank eines serverlosen Erlebnisses.

Elastische Auto-Skalierung, nutzungsbasierte Preisgestaltung und Rechenkapazitätsgrenzen sorgen für ein ausgewogenes Verhältnis zwischen Leistung und Kosten. Eine browserbasierte Benutzeroberfläche, CLI oder VS Code-Erweiterung, gekoppelt mit integrierten Monitoring-Tools wie Stream-Lineage bieten die benötigte Flexibilität, um die Entwicklung von der Testphase bis zur Produktion zu beschleunigen.

Voll auf die Entwicklung konzentrieren

Confluent Code übernimmt alles andere dank unserer Cloud-nativen, serverlosen Flink-Lösung

Flink SQL-Workspaces

Die primäre, browserbasierte Option, um SQL für die Interaktion mit den Daten in Confluent Cloud zu nutzen

Confluent-CLI

Statements und Compute-Pools in der CLI verwalten

VS Code-Erweiterung

Fokussierte Entwicklung dank VS Code-Erweiterung

Entwickeln in einer Welt, in der KI an erster Stelle steht

Responsive Echtzeit-KI/ML-Systeme und Event-getriebene Agenten erstellen.

Daten für Echtzeit-Inferenz vorbereiten mit Einbettungs-, Prognose- und Inferenz-Funktionen und sie nahtlos mit externen Modellen, LLMs, Tools und Frameworks integrieren. Den AI-Technologie-Stack vereinfachen und den Fokus von der Integration auf die Bereitstellung von AI-Mehrwert verlagern.

Echtzeit-Einbettung

Vektoreinbettungen für Daten innerhalb von Streaming-Pipelines generieren.

Echtzeit-Forecasting

Echtzeit-Forecasting während Events durch die Streaming-Pipelines fließen

Echtzeit-Inferenz

Inferenzen auf Events innerhalb des Streams durchführen

Tool-Calling

OOTB-Unterstützung für Tool-Calling mit MCP

„Die Stream-Verarbeitung ist ein entscheidender Faktor, um Sicherheitsrisiken in Echtzeit zu erkennen und sich gegen sie zu schützen. Mit dem vollständig verwalteten Flink-Angebot von Confluent können wir auf Daten von IoT-Sensoren, intelligenten Kameras und WLAN-Analytics zugreifen, diese aggregieren und anreichern, um auf potenzielle Bedrohungen in Echtzeit reagieren zu können, z. B. bei der Erkennung von Eindringlingen. Dadurch können wir Sensordaten verarbeiten, sobald die Ereignisse eintreten, was eine schnellere Erkennung und Reaktion auf Sicherheitsvorfälle ohne zusätzlichen operativen Aufwand ermöglicht."

„Die Stream-Verarbeitung ist ein entscheidender Faktor, um Sicherheitsrisiken in Echtzeit zu erkennen und sich gegen sie zu schützen. Mit dem vollständig verwalteten Flink-Angebot von Confluent können wir auf Daten von IoT-Sensoren, intelligenten Kameras und WLAN-Analytics zugreifen, diese aggregieren und anreichern, um auf potenzielle Bedrohungen in Echtzeit reagieren zu können, z. B. bei der Erkennung von Eindringlingen. Dadurch können wir Sensordaten verarbeiten, sobald die Ereignisse eintreten, was eine schnellere Erkennung und Reaktion auf Sicherheitsvorfälle ohne zusätzlichen Betriebsaufwand ermöglicht.“

„Wir nutzen Apache Flink, um unsere Daten zu verarbeiten, bevor sie Snowflake erreichen, und so unnötige Kosten zu vermeiden. Bei einem Data Warehouse sprechen wir von Milliarden von Datenpunkten in einer Tabelle, und die Verarbeitung dieser Daten nach der Speicherung ist extrem teuer. Heute fließen unsere Daten kontinuierlich – in Flink. Wir verarbeiten Sie in Zeitfenstern, während sie sich durch das System bewegen. Alle Daten können in einem Stream an das Data Warehouse gesendet und gleichzeitig aggregiert werden, um sie an eine andere Speicherplattform downstream zu senden – das ist viel kostengünstiger und effizienter.“

„Mit Flink haben wir jetzt die Möglichkeit, die Verarbeitung nach links zu verschieben und viele Datentransformationen und Rechenvorgänge an unseren Daten frühzeitig durchzuführen, bevor sie Snowflake erreichen. Dies wird unsere Datenverarbeitungskosten optimieren, um die Menge der uns zur Verfügung stehenden Daten erhöhen können.“

Neue Entwickler erhalten Credits im Wert von 400 $ für die ersten 30 Tage – kein Kontakt zum Vertrieb erforderlich.

Confluent bietet alles Notwendige zum: – Entwickeln mit Client-Libraries für Sprachen wie Java und Python, Code-Beispielen, über 120 vorgefertigten Connectors und einer Visual Studio Code-Extension. – Lernen mit On-Demand-Kursen, Zertifizierungen und einer globalen Experten-Community. – Betreiben mithilfe einer CLI, IaC-Unterstützung für Terraform und Pulumi und OpenTelemetry-Observability.

Die Registrierung ist über das Cloud-Marketplace-Konto unten möglich oder direkt bei uns.

Confluent Cloud

Ein vollständig verwalteter cloud-nativer Service für Apache Kafka®

Möglichkeiten, mit der Verarbeitung zu beginnen

Stream Processing With Confluent | FAQs

What is Apache Flink and why is it used for stream processing?

Apache Flink is the de facto open-source standard for stateful stream processing, designed to run computations over unbounded, continuous data streams. It's used for building real-time data pipelines and event-driven applications because it provides low-latency processing, high throughput, and exactly-once consistency guarantees, which are critical for trustworthy, mission-critical systems.

Do I need Apache Kafka to use Confluent's Flink service?

Yes. Confluent Cloud is designed as a unified data streaming platform where Apache Kafka and Apache Flink are seamlessly integrated. Data must be in a Confluent Cloud Kafka topic to be processed by Flink. This tight integration is a core benefit, as it removes the need for custom connectors and provides a single, governed source of truth for all real-time data. However, Confluent Platform enables use of Flink with a variety of sources outside Apache Kafka.

How is Confluent's serverless Flink different from open-source Apache Flink?

Confluent Cloud provides a fully managed, serverless Flink service that eliminates the significant operational complexity of deploying, scaling, and securing open-source Flink. While open-source Flink is a powerful engine, Confluent provides a complete data streaming platform around it, including zero-config integration with Kafka, an integrated Schema Registry, enterprise-grade security, and a usage-based pricing model, allowing teams to focus on logic, not infrastructure.

How can I control costs with Flink's usage-based pricing?

Confluent Cloud provides several tools for cost management. The pricing is pay-as-you-go, based on CFUs consumed per minute, so you only pay for what you use. You can set configurable, hard spending limits on your compute pools to prevent budget overruns and monitor usage through the Metrics API to optimize your queries for cost-efficiency.