[Webinar] Die Grundlagen von Apache Kafka mit Confluent meistern | Jetzt registrieren

Einfache, serverlose Stream-Verarbeitung

Mühelos hochwertige, wiederverwendbare Datenströme erstellen mit dem branchenweit einzigen serverlosen Apache Flink®-Service, der vollständig mit Apache Kafka® in Confluent Cloud in allen drei großen Clouds integriert ist.

Confluent Platform für Apache Flink® ist jetzt standardmäßig für On-Premise- und Private-Cloud-Workloads verfügbar – Details dazu gibt es hier.

Keine Echtzeit-Anwendungsfälle ohne Echtzeit-Verarbeitung

Echtzeit-Datennutzung ermöglichen, indem Daten, während sie durchs Unternehmen fließen, transformiert, analysiert und verarbeitet werden:

- Shift Left Daten-Pipelines: Daten bereinigen und anpassen, sobald sie entstehen, um Data-Warehouses oder Data Lakes stets mit aktualisierten, zuverlässigen und wiederverwendbaren Daten zu versorgen.

- Materialized Views in Echtzeit: Nachgelagerte Systeme und Anwendungen mithilfe von inkrementell aktualisierten universellen Echtzeit-Datenprodukten synchronisieren.

- Klassische Event-Verarbeitung: Events erfassen und verarbeiten, sobald sie entstehen und im Laufe der Zeit aggregieren und analysieren, um Trends, Muster und Anomalien zu erkennen.

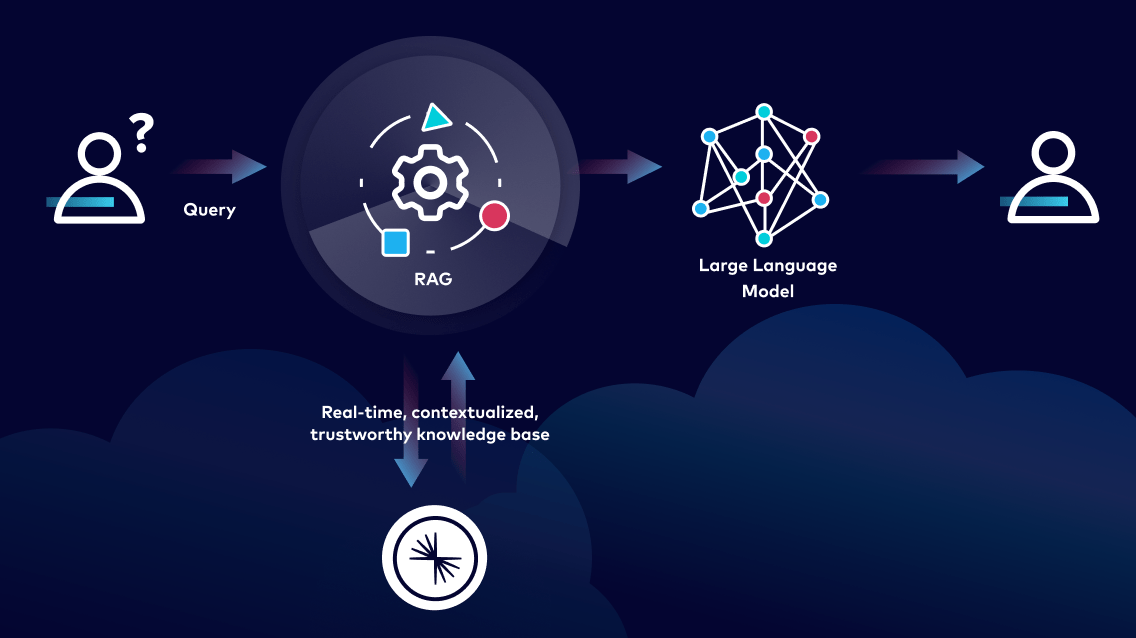

Accelerate Real-Time AI Pipelines

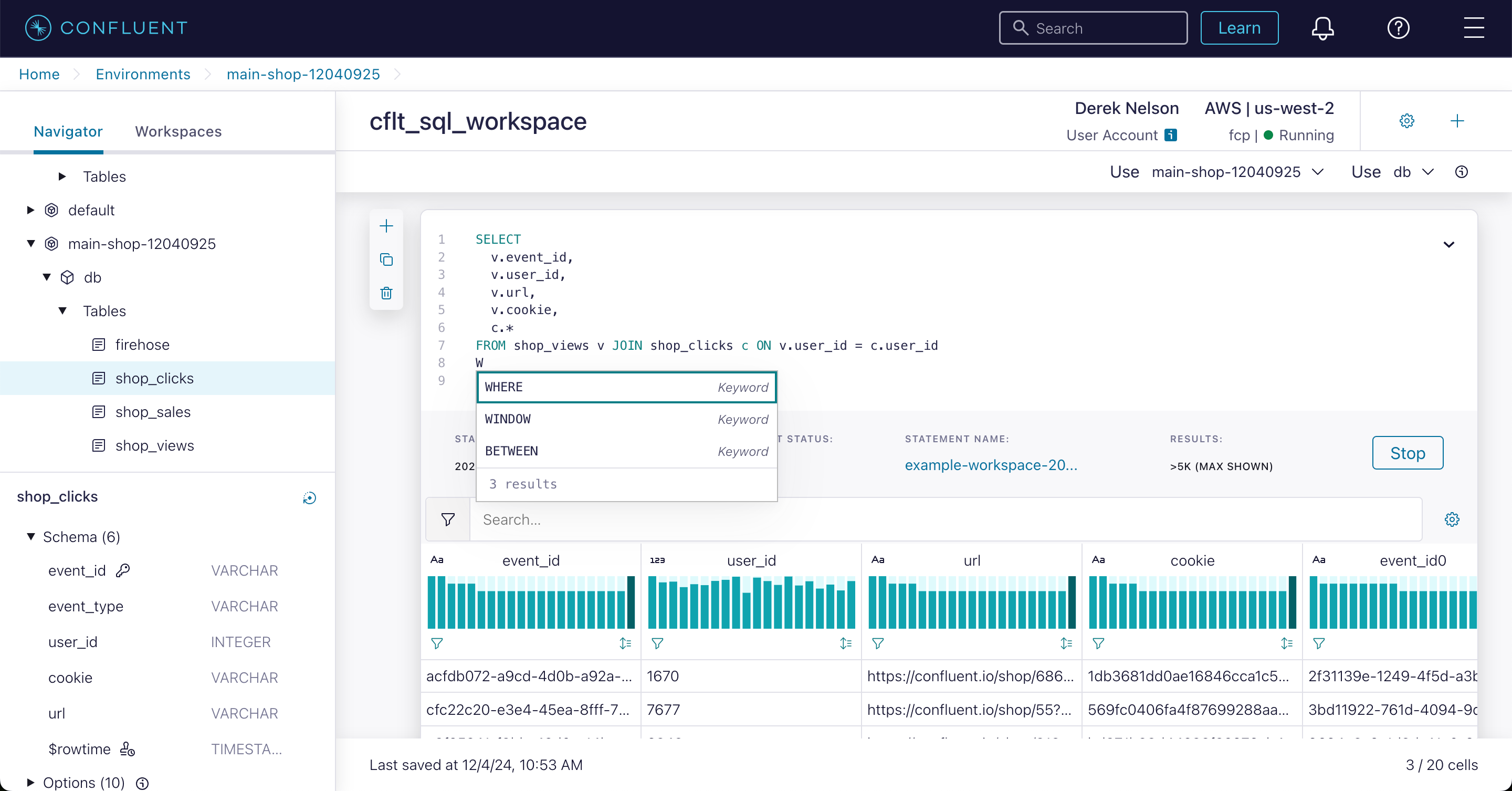

Use Flink AI Model Inference with familiar SQL syntax to work directly with LLMs and vector databases to make accurate, real-time AI-driven decisions based on the most current and relevant streaming data.

Filtern. Verbinden. Anreichern.

Mit Flink, dem De-facto-Standard für die Datenstromverarbeitung, Datenströme mühelos filtern, verbinden und anreichern.

Echtzeitverarbeitung

Anwendungen und Pipelines mit geringer Latenz nutzen, die auf Echtzeit-Events reagieren und zeitnahe Erkenntnisse liefern.

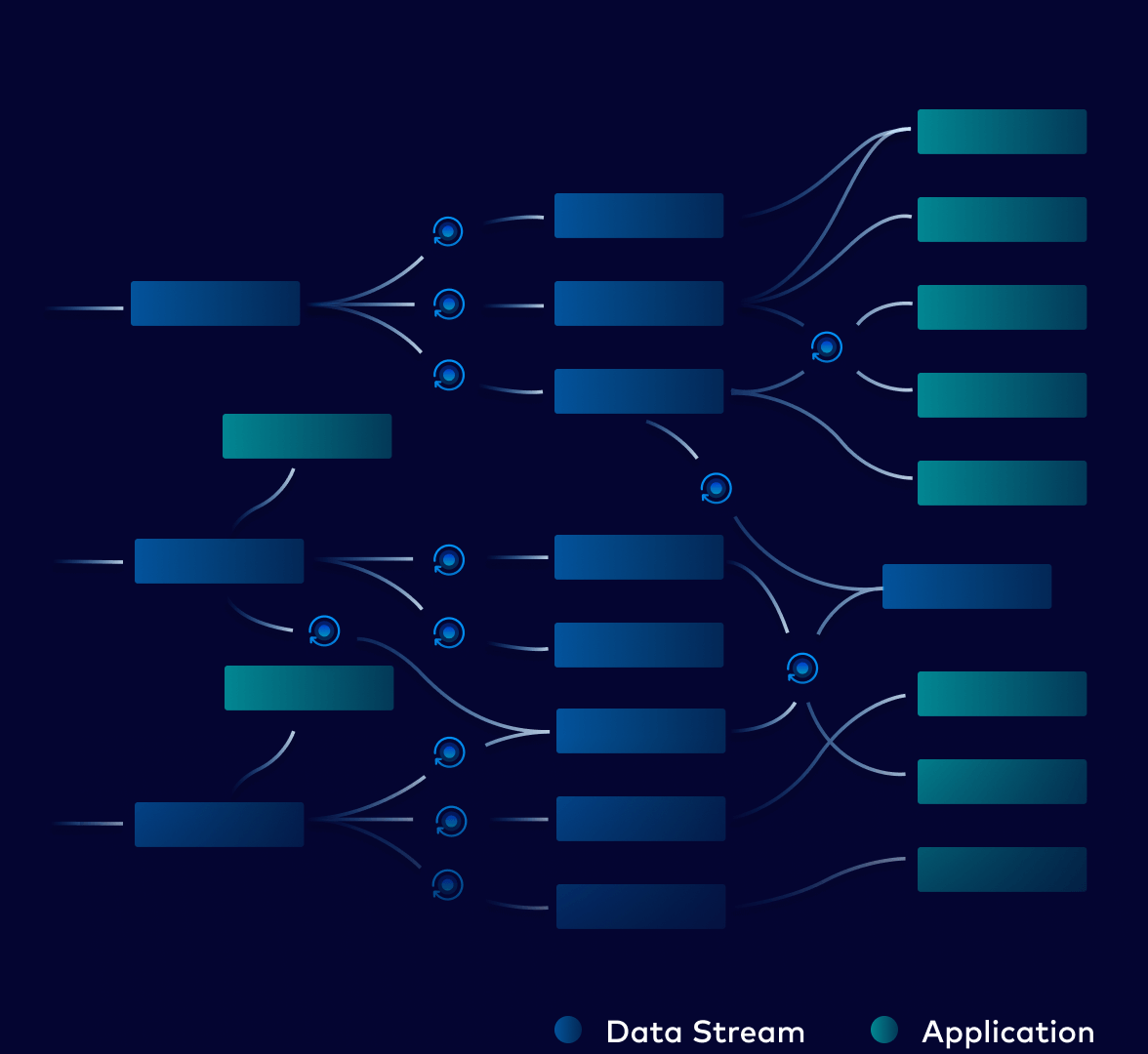

Wiederverwendbarkeit von Daten

Konsistente und wiederverwendbare Datenströme im großen Umfang mit nachgelagerten Anwendungen und Systemen teilen.

Datenanreicherung

Daten im Handumdrehen kuratieren, filtern und mit zusätzlichem Kontext ergänzen, um Vollständigkeit, Genauigkeit und Compliance zu verbessern.

Effizienz

Verbesserte Ressourcennutzung und Kosteneffektivität, indem redundante Verarbeitung zwischen Silos vermieden werden.

Cloud-natives Erlebnis

Leistungsstarke und effiziente Datenstromverarbeitung in jeder Größenordnung, ohne komplexes Infrastrukturmanagement.

Vollständig verwaltet

Ganz einfach Flink-Anwendungen mit einer serverlosen, SaaS-basierten Lösung entwickeln, die sofort verfügbar ist und keinen operativen Aufwand verursacht.

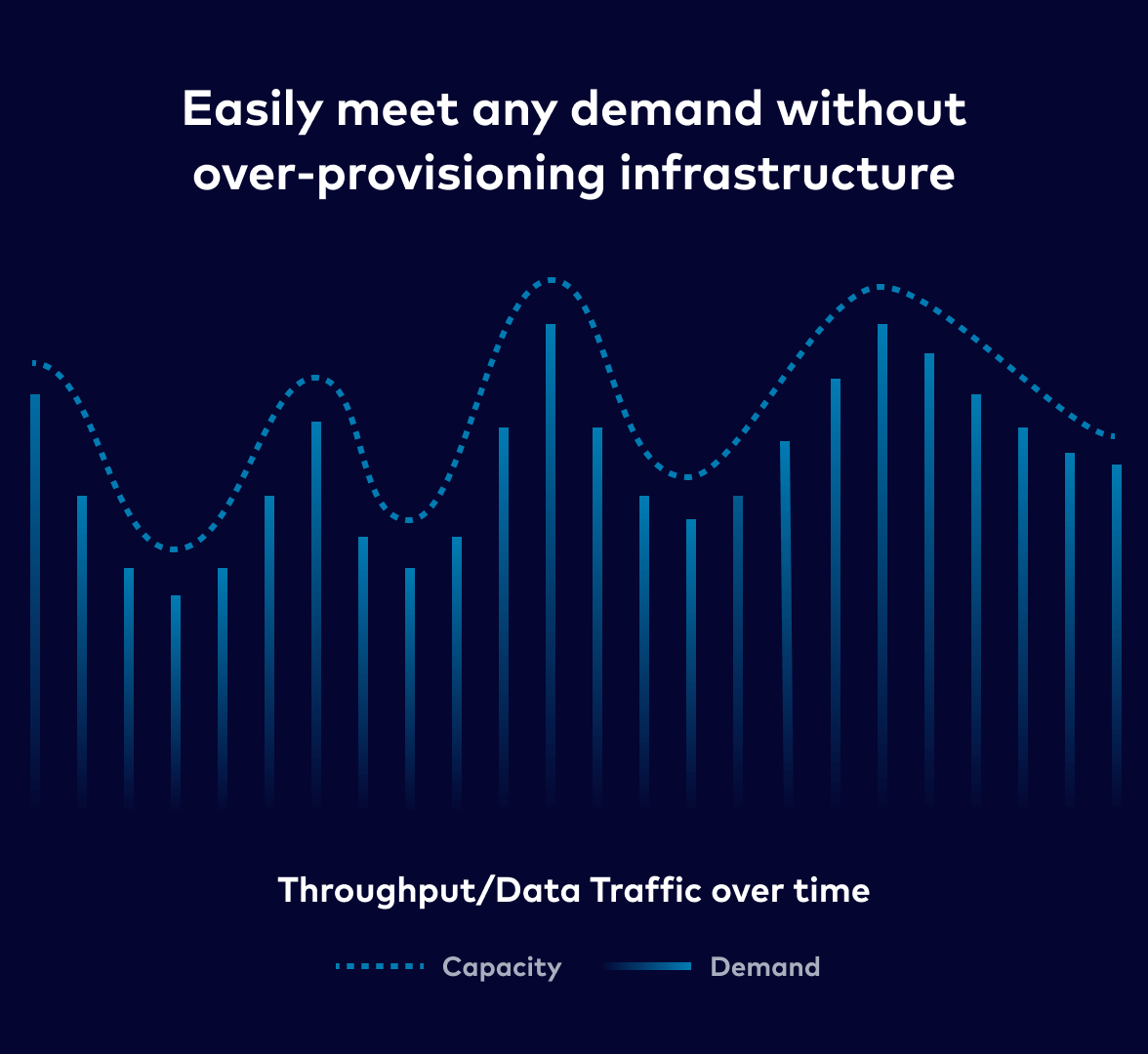

Elastische Skalierbarkeit

Automatisches Hoch- oder Herunterskalieren, um die Anforderungen der komplexesten Workloads zu erfüllen und eine Überprovisionierung zu vermeiden.

Infrastructure-as-Code

Automatisierung von Flink-Deployments auf Kubernetes für Private-Cloud- und On-Premise-Workloads

Kontinuierliche Updates

Automatisierte Upgrades ermöglichen die Entwicklung mit einer stets aktuellen Plattform

Kafka + Flink, vereint

Kafka und Flink gemeinsam nutzen - als umfassende Daten-Streaming-Plattform auf Enterprise-Niveau.

Sicherheit auf Enterprise-Niveau

Sichere Datenstromverarbeitung mit integrierter Identitäts- und Zugriffsverwaltung, RBAC und detaillierten Audit-Logs

Stream Governance

Universelle Datenstandards definieren und durchsetzen, die eine skalierbare Datenkompatibilität ermöglichen

Monitoring

Zuverlässigen, effizienten und mühelosen Betrieb von Flink-Anwendungen gewährleisten

Connectors

Verbindungen zu und mit jeder Anwendung und jedem System erstellen, dank mehr als 120 vorgefertigter Connectors