[Live Lab] Streaming 101: Hands-On with Kafka & Flink | Secure Your Spot

Mehr als 120 vorgefertigte Connectors

Schnellere unternehmensweite Verknüpfung

Datensilos aufbrechen dank über 120 vorgefertigten Connectors für alle Datenquellen oder -Sinks.

Pro Connector 3–6 Monate Entwicklungszeit sparen

Save 3-6 months of development per connector

Legacy- und Cloud-Systeme verbinden zur Modernisierung des Tech-Stacks

Modernize your tech stack by bridging legacy & cloud systems

Operativen Aufwand, Risiken und TCO reduzieren dank vollständig verwalteter Connectors

Reduce ops burden, risk, & TCO with fully managed connectors

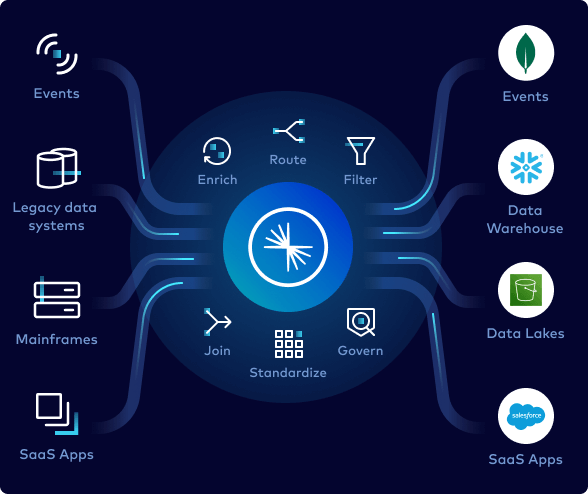

Kafka Connect ist der offene Standard für die Integration von Daten in und aus Apache Kafka®.

Confluent macht Kafka Connect noch besser, mit dem größten Portfolio von über 120 vorgefertigten Connectors auf dem Markt—alle mit Sicherheit, Zuverlässigkeit und Support auf Enterprise-Niveau, um Risiken und den Betriebsaufwand zu reduzieren.

GenAI-Apps schneller entwickeln mithilfe von Connectors

Wie eine Echtzeit-Knowledge-Base für eine RAG-Architektur erstellt werden kann

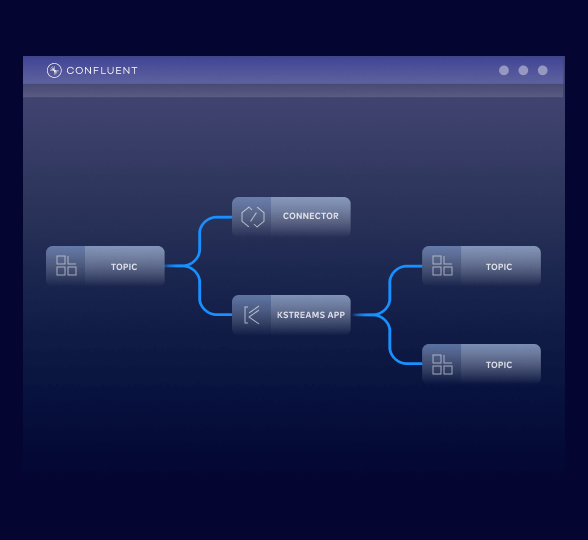

Daten integrieren, ohne Code

Einzelne Teams sollten nicht länger generische Integrationen schreiben und Connectors verwalten müssen

Einfach den benötigten Connector definieren, seine Quellen und Sinks identifizieren und innerhalb des privaten Netzwerks mit dem Streaming loslegen – via Konfigurationsdatei, UI oder API.

Confluent bietet über 120 Integrationen mit:

Vorgefertigten Connectors

Pro Connector können 3‑6 Entwicklungsmonate für Design, Erstellung und das Testen eingespart werden.

Vollständig verwalteten Connectors

Innerhalb weniger Minuten loslegen, ohne operativen Overhead und gleichzeitig die Gesamtbetriebskosten senken

Custom Connectors

Eigene Connectors für Custom-Apps nutzen, wir übernehmen die Verwaltung der Connect-Infrastruktur.

Security und Support auf Enterprise-Niveau

Unternehmenskritische Workloads mit Private Networking, 99,99 % Uptime-SLA, RBAC und Expertensupport

Tech-Stack modernisieren

Mühelos Daten-Streaming-Pipelines mithilfe von Connectors erstellen zur Anbindung von Legacy-Systemen an moderne Cloud-Technologien.

Confluent-Connectors umfassen:

Datenbanken

Mit CDC-Connectors kann die Migration von Legacy-Datenbanken zu Cloud-nativen Datenbanken beschleunigt und das Risiko verringert werden

Data Warehouses

Echtzeitdaten in Cloud-Data-Warehouses streamen, damit Datenteams mit den neuesten Informationen arbeiten können

Data Lakes

Data Lakes versorgen und die Datenarchitektur vereinfachen dank entkoppelter Datenquellen und -Sinks

SaaS-Anwendungen

Alle SaaS-Apps verbinden, damit Daten aus allen Geschäftsbereichen von allen anderen genutzt werden können.

Laufenden Betrieb vereinfachen

Confluent bietet umfassende Kontrolle und Übersicht über die gesamte Umgebung.

Workflow optimieren mit:

AWS IAM AssumeRole

Zugriff auf AWS-Ressourcen unternehmensweit einfach und sicher verwalten mit temporären Anmeldeinformationen

Instant-Config-Validierung

Feedback und Fehler-Alerts für Feldeingaben, um Connectors erfolgreich zu starten

Client-Side Field Level Encryption

Die Möglichkeit, Datensätze innerhalb des Connectors zu verschlüsseln und zu entschlüsseln unterstützt hochsensible Workloads.

Benutzerdefinierte Transformationen einzelner Messages

Einfache Datentransformationen wie Maskierung und Filterung sofort innerhalb des Quell- oder Sink-Connectors und vor der Stream-Verarbeitung durchführen.

Protokoll- und Metrik-Monitoring

Connector-Events in der Konsole geben Kontextinformationen und helfen bei der Fehlerbehebung

„Dank der leistungsstarken, vollständig verwalteten Connectors können wir Daten mühelos an Ziele wie Amazon S3 streamen, wodurch das Echtzeit-Event-Logging skalierbar und effizient wird. Confluent verfügt über eine umfangreiche Bibliothek mit vorgefertigten Connectors, die es uns ermöglichen, schnell Prototypen zu erstellen, bevor wir uns für einen endgültigen Ansatz entscheiden.“

EVO Banco konnte dank praktisch unbegrenzter Connectors auf eine Vielzahl von Datenquellen zugreifen. Die Konfiguration war unkompliziert; einfach den gewünschten Datentyp auswählen und die Verbindungsdaten eingeben. Auf diese Weise konnte das Unternehmen sofort und nahtlos mit der Datenübertragung beginnen.

„Confluent Fully Managed Connectors ermöglichen es uns, Innovationen zu beschleunigen… jetzt können wir unsere Entwicklungsressourcen in die Entwicklung neuer Funktionen investieren, anstatt in Custom-Integrationen zu gängigen Datenquellen.“

Neue Entwickler erhalten Credits im Wert von 400 $ für die ersten 30 Tage – kein Kontakt zum Vertrieb erforderlich.

Confluent bietet alles Notwendige zum: – Entwickeln mit Client-Libraries für Sprachen wie Java und Python, Code-Beispielen, über 120 vorgefertigten Connectors und einer Visual Studio Code-Extension. – Lernen mit On-Demand-Kursen, Zertifizierungen und einer globalen Experten-Community. – Betreiben mithilfe einer CLI, IaC-Unterstützung für Terraform und Pulumi und OpenTelemetry-Observability.

Die Registrierung ist über das Cloud-Marketplace-Konto unten möglich oder direkt bei uns.

Confluent Cloud

Ein vollständig verwalteter cloud-nativer Service für Apache Kafka®

Confluent Connectors | FAQS

Can I modernize legacy systems with Confluent connectors?

Confluent offers a portfolio of more than 120 pre-built, enterprise grade connectors that make it easy for you to connect external systems to your Kafka deployments. By taking advantage of these connectors, you no longer have to write, test, and maintain integration code just to get your data into and out of Kafka topics.

That means you can easily modernize legacy systems with Confluent—easily connect your legacy databases, mainframes, and messaging systems to cloud data services and platforms with Confluent as your intermediary data access layer.

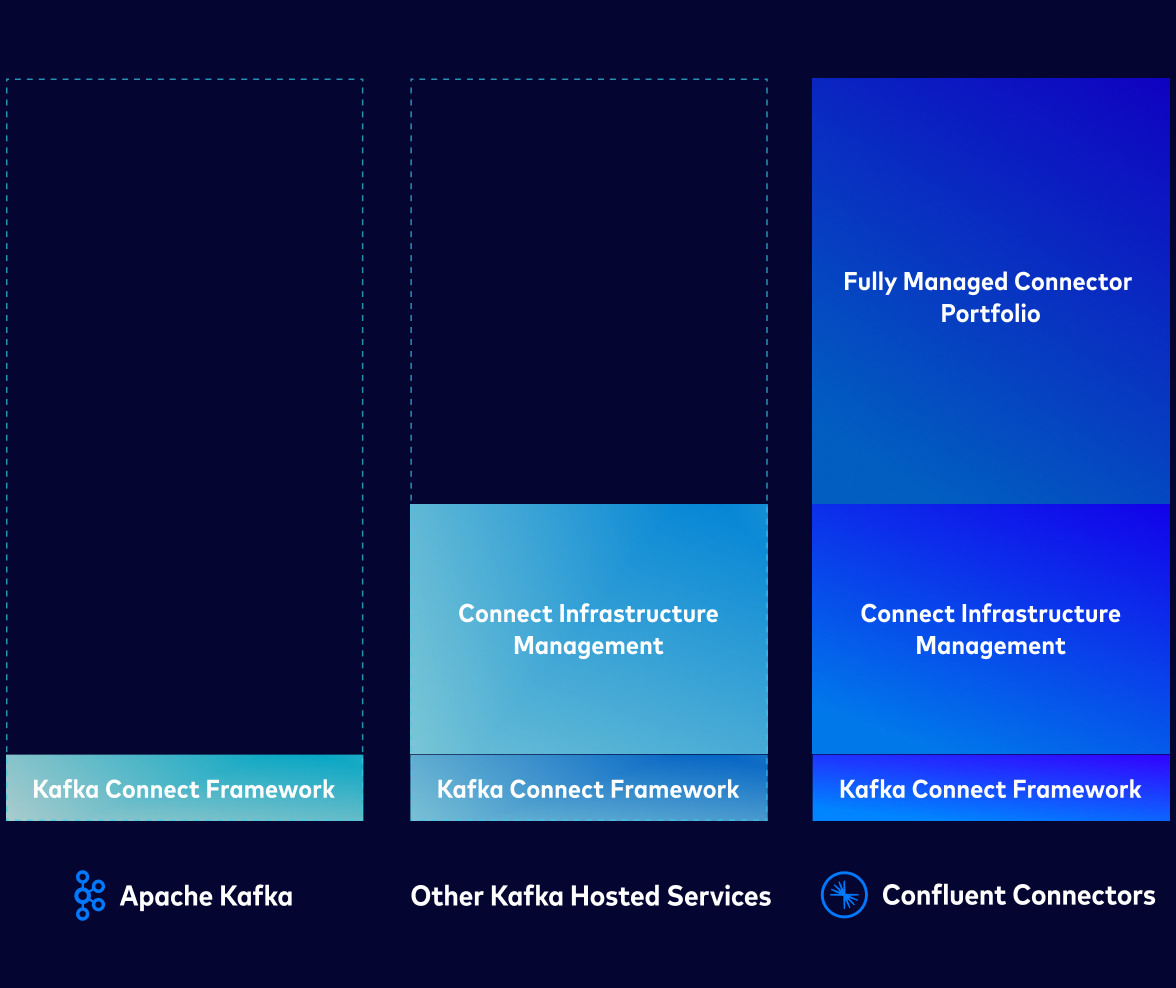

What makes Confluent-managed connectors different from open source Kafka Connect?

Confluent offers 80+ fully managed connectors, which means that you don’t have to manage connector plugins or their underlying infrastructure and can offload provisioning, upgrades, and patching.

Confluent-managed connectors eliminate integration overhead for your Kafka deployments and come with a 99.99% uptime SLA for production workloads. As a result, using these connectors frees your engineering teams from the burden of managing integration code and infrastructure. Instead, your teams can focus on building applications and unlocking the value of your data.

Other key operational benefits include:

- Seamless Upgrades: Features like plugin versioning for custom connectors allow for smooth upgrades without losing offsets or disrupting service.

- Improved Troubleshooting: Non-admin roles can now access connector logs, empowering them to manage and diagnose their own connectors without escalating to an administrator.

- Less Maintenance: Confluent manages all the underlying infrastructure so your team doesn't have to worry about provisioning, patching, or scaling the Connect environment.

How do Confluent connectors help reduce total cost of ownership (TCO)?

Confluent's fully managed connectors help lower your Kafka TCO by eliminating the costs associated with building and maintaining the integration code in connector plugins and from self-managing a Kafka Connect environment.

Key savings come from:

- Cost-Efficient Infrastructure Scaling: Elastic scaling for all Confluent connectors and autoscaling with fully managed connectors enables you to scale and consume compute resources more efficiently.

- Reduced Operational Burden: With fully managed connectors, you save on the engineering time and resources needed for maintenance, troubleshooting, and upgrades. High-availability reduces the business impact of unplanned pipeline downtime.

- Increased Developer Productivity: With simplified, secure streaming integration, your developer teams spend less time blocked by data access issues and can dedicate more resources to building real-time applications and event-driven systems across the organization. And using pre-built connectors can help cut 3-6 months from your production timelines.

How does Confluent’s price guarantee apply to connectors?

Confluent will beat or match the price of Kafka services from your hyperscaler, allowing you to save money on your streaming workloads—including when it comes to your Connect tasks.

Visit the Confluent Cost Estimator to see how much you can save as you scale seamlessly and cost-effectively with Confluent. Explore the volume-based discounts that you can access for Connect tasks with annual commitments for Confluent Cloud.

What security and compliance features are available for sensitive data?

Confluent connectors are built with enterprise-grade features for security, reliability, and developer productivity including secure private networking configurations, built in single message transforms (SMTs), and more.

Confluent helps ensure that the streaming data pipelines you build are secure and compliance, with purpose-built features for handling sensitive data:

- Granular Access Control: Enhanced role-based access control (RBAC) allows you to grant users the specific permissions they need to manage connectors without giving them full admin rights.

- Secure Networking: You can connect to data systems in private networks using features like DNS Forwarding and Egress PrivateLink, restricting traffic from the public internet.

- Data Masking: You can use single-message transforms (SMTs) to perform lightweight transformations on connector workloads, including masking sensitive data field within a data stream.

- Data Encryption: Specific connectors, like the one for Oracle XStream, support client-side field level encryption (CSFLE) to ensure data remains secure continuously.

- Advanced Authentication: Many connectors support modern, secure authentication methods like AWS IAM AssumeRole, which removes the need for long-lived access keys. Others support protocols like OAuth2 and SSO integration.

How quickly can I launch a connector in Confluent Cloud?

You can launch fully managed connectors in seconds with no-code provisioning and real-time configuration checks, Simply find the fully managed connector you need on Confluent Cloud and hit launch or access them directly from your Confluent Cloud account.

Self-managed connectors require more initial setup to run alongside your cloud deployment. Search Confluent Hub to find self-managed Confluent, partner, and community-built connectors and then visit Docs to learn how to connect self-managed Kafka Connect to Confluent Cloud.

Do I need to browse the Connector Hub to get started?

While you don't need to browse Confluent Hub to get started, it is a great way to see all the options available for your self-managed and fully managed Kafka deployments. The Hub helps you discover what integrations are available via Confluent, as well as find open source and partner-verified connectors beyond the 120+ that we offer.

If you’re looking specifically for fully managed connectors to use on AWS, Microsoft Azure, or Google Cloud, you can log in to the Cloud Console and launch connectors in just a few clicks.

Can I bring my own custom connector to Confluent Cloud?

Yes, you can bring your custom and in-house built connectors to Confluent Cloud. The platform now supports plugin versioning for custom connectors, which allows you to upload a new version of your plugin and seamlessly direct active connectors to it, resuming from the last offset. This is managed through the new Custom Connect Plugin Management (CCPM) APIs.

How do Confluent connectors support real-time AI and analytics initiatives?

Confluent connectors are the foundational layer for real-time AI and analytics, as they feed live data streams from across your business into the platforms where this analysis occurs. Capture changes as they happen from databases like PostgreSQL and Oracle using Confluent’s CDC connectors.

Then, stream the real-time events needed for AI/ML models and analytics dashboards to understand and act on the state of the business. Combined with sink connectors for major analytics and data warehouse platforms—such as Snowflake and Amazon Redshift—this allows you to stream processed, enriched data directly into these systems for immediate use. This ability to build real-time pipelines is essential for unlocking new AI and analytics use cases.