[Live Lab] Streaming 101: Hands-On with Kafka & Flink | Secure Your Spot

VOLLSTÄNDIG VERWALTET | CONFLUENT CLOUD

Echtzeitdaten nutzen, Kosten senken – jede Skalierung, jede Cloud.

Confluent Cloud ist das vollständig verwaltete Deployment unserer Daten-Streaming-Plattform. Die serverlose Apache Kafka-Engine® bietet die effizienteste Lösung, Echtzeit-Datenströme in der Cloud bereitzustellen und zu skalieren. Aber das Streamen der Daten ist nur der Anfang.

Jetzt erfahren, wie Confluent Cloud hilft, die Kafka-Kosteneinsparungen zu maximieren, die Sicherheit zu optimieren und hybride Deployments zu integrieren.

Infrastrukturkosten halbieren dank automatischer Cluster-Skalierung

Überprovisionierte und nicht ausgelastete Kafka-Cluster waren einmal. Angetrieben von Kora, unserer Cloud-nativen Kafka-Engine, skaliert Confluent Cloud automatisch, um sicherzustellen, dass die Infrastruktur immer optimal auf den Workload abgestimmt ist. Nur noch für die Kapazitäten zahlen, die tatsächlich benötigt werden und dadurch die Infrastrukturausgaben halbieren.

Basic- und Standard-Cluster

Jetzt mit Basic-Clustern ohne Risiko loslegen oder produktionsreife Anwendungsfälle auf Standard-Clustern einrichten, um von unbegrenztem Speicherplatz, Audit-Protokollen zur Threat Detection und über 20 % Durchsatz-Einsparungen zu profitieren.

Enterprise-Cluster

Enterprise-Cluster für unternehmenskritische Anwendungsfälle ermöglichen, vertrauliche Daten im privaten Netzwerk optimal zu schützen, automatische Skalierung im GBps+ Bereich und Durchsatz-Einsparungen von über 32 %.

Freight Cluster

Freight-Cluster nutzen, um Durchsatz-Einsparungen von bis zu 90 % bei hochvolumigen Workloads wie Logging, Observability und KI/ML-Dateneinspeisung zu erzielen.

Multi-Region- und Multicloud-Cluster

Mit Cluster Linking können Daten direkt von einem Confluent Cloud-Cluster zu einem anderen repliziert, synchronisiert und weitergegeben werden – auch wenn sich die Cluster in unterschiedlichen Regionen, öffentlichen Clouds oder Unternehmen befinden.

Apache Kafka®-Ops auslagern, um die Gesamtbetriebskosten um 60 % zu senken und die Entwicklung zu beschleunigen

Skalierungs-, Budget- und Zeit-Limits beseitigen und gesamten operativen Aufwand an Confluent Cloud auslagern, mit ausfallsicherem, serverlosem Daten-Streaming, verfügbar in den drei großen Public Clouds. Mit nutzungsabhängiger Abrechnung und kosteneffizienten Clustern für jeden Workload reduziert Confluent Cloud die Gesamtbetriebskosten (TCO) für self-managed Kafka um bis zu 60 % – und verschafft die Freiheit und den Fokus für die wichtigen Aufgaben.

Die flexiblen Clusteroptionen von Confluent Cloud maximieren die Kosteneinsparungen zusätzlich. Cluster-Typen basierend auf den individuellen Anforderungen des Anwendungsfalls kombinieren und gleichzeitig die Verfügbarkeit von unternehmenskritischen Workloads mit unserem 99,99 % Uptime-SLA sicherstellen.

Citizens Bank senkt IT-Kosten und spart jährlich 1 Mio. USD

Citizens Bank erfasst Änderungsdaten unternehmensweit in Echtzeit. Jetzt erfahren, wie Confluent Cloud dazu beitrug, IT-Kosten zu senken und die Datenverarbeitung um 50 % zu beschleunigen.

Dank Confluent spart BigCommerce über 20 Stunden pro Woche ein

Wie BigCommerce Confluent Cloud zur Automatisierung der Wartung nutzt und den Traffic am Black Friday auf Google Cloud elastisch skaliert.

Victoria’s Secret beschleunigt Geschäftsentscheidungen mit Confluent

Wie Victoria's Secret durch die Einführung von Confluent Cloud die operative Effizienz mit Echtzeitanalysen für eine schnellere Entscheidungsfindung steigern konnte.

Umfassende Funktionen für Sicherheit auf Enterprise-Niveau und eine moderne Datenarchitektur

Dank der richtigen Kombination von Funktionen hilft eine umfassende Daten-Streaming-Plattform, unzuverlässige Punkt-zu-Punkt-Integrationen unternehmensweit abzulösen, um einen sicheren und zuverlässigen Echtzeitzugriff auf hochwertige Daten zu ermöglichen.

Regulatorische Compliance mit zuverlässigen Sicherheitskontrollen gewährleisten

Authentifizierung mühelos verwalten, Zugriffe auf Cloud-Ressourcen steuern, Datenströme verschlüsseln und Sicherheitsrisiken überwachen und bewerten. Alle Security-Features – einschließlich RBAC, selbst verwaltete Encryption Keys, Client-Side Field Level Encryption und Audit-Logs – wurden konzipiert, um höchste Datenschutzanforderungen zu erfüllen.

Mühelose Integration von Datensystemen dank vollständig verwalteten Connectors

Kafka Connectors zu entwerfen, zu erstellen, zu testen und zu warten, dauert oft Monate – und sie selbst zu verwalten noch länger. Confluent kann dank mehr als 120 vorgefertigten und über 80 vollständig verwalteten Kafka Connectors mühelos mit allen Quellen und Sinks wie Datenbanken, Data Lakes und Data Warehouses verbunden werden.

Daten nah an der Quelle steuern und verarbeiten zur Wiederverwendung downstream

Confluent Cloud für Apache Flink® und Stream Governance ermöglichen ein Shift Left der Datenverarbeitung und Governance, um fehlerhafte Daten zu verhindern und Rechenkosten zu senken. Dadurch lassen sich Analysen erstellen und KI-fähige Datenprodukte entwickeln, die unternehmensweit weitergegeben, entdeckt und für Anwendungsfälle wiederverwendet werden k�önnen.

Mit Tableflow Datenströme in Analysetabellen umwandeln

Mit nur wenigen Klicks ermöglicht Tableflow, Kafka-Topics und -Schemata als Apache Iceberg™- und Delta Lake-Tabellen zu erstellen. So können Data Lakes, Data-Warehouses und Analyse-Engines, die KI-Anwendungsfälle antreiben, mit aktuellen, vertrauenswürdigen und angereicherten Daten versorgt und in die Lösungen unserer Partner integriert werden.

Daten über globale, hybride Umgebungen hinweg vereinheitlichen

Die Daten-Streaming-Plattform ist überall dort einsetzbar, wo sich die Daten befinden – vollständig verwaltet in über 100 Regionen von Amazon Web Services, Microsoft Azure und Google Cloud, im eigenen Cloud-Account verwaltet über WarpStream oder self-managed in On-Prem- und Private-Cloud-Umgebungen mit Confluent Platform.

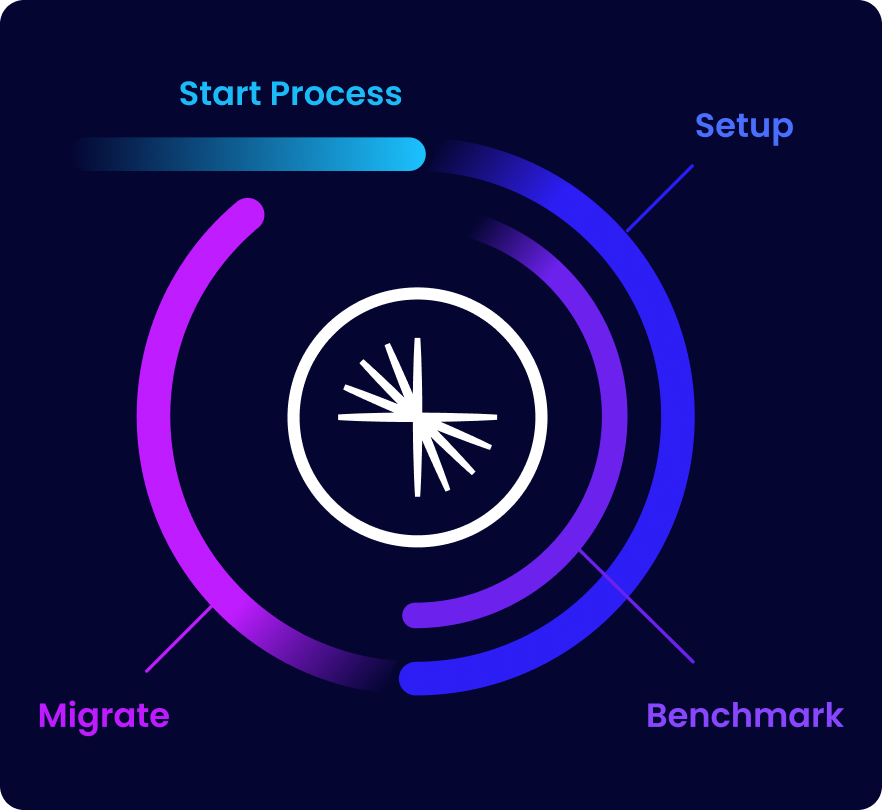

Und mit Cluster Linking können Daten in hybriden und Multi-Cloud-Deployments integriert werden, sowohl über öffentliche als auch private Netzwerke, um eine einzige globale Datenebene bereitzustellen, auf der alle Umgebungen verbunden sind. Dies ermöglicht einheitliche Überwachung und Verwaltung und macht komplexe Punkt-zu-Punkt-Verbindungen überflüssig. Dadurch lassen sich mühelos: – Confluent Platform- und Confluent Cloud-Cluster miteinander verbinden – Daten zwischen Confluent Platform- und Confluent Cloud-Clustern migrieren – Daten auf Confluent Cloud über Cluster, Regionen und Clouds hinweg weitergeben

Deep Dive in Confluent Cloud und seine Features

Neue Entwickler erhalten Credits im Wert von 400 $ für die ersten 30 Tage – kein Kontakt zum Vertrieb erforderlich.

Confluent bietet alles Notwendige zum: – Entwickeln mit Client-Libraries für Sprachen wie Java und Python, Code-Beispielen, über 120 vorgefertigten Connectors und einer Visual Studio Code-Extension. – Lernen mit On-Demand-Kursen, Zertifizierungen und einer globalen Experten-Community. – Betreiben mithilfe einer CLI, IaC-Unterstützung für Terraform und Pulumi und OpenTelemetry-Observability.

Die Registrierung ist über das Cloud-Marketplace-Konto unten möglich oder direkt bei uns.

Confluent Cloud

Ein vollständig verwalteter cloud-nativer Service für Apache Kafka®

Confluent Cloud FAQs

What is Confluent Cloud?

Confluent Cloud is the industry's only fully managed data streaming platform. With Confluent Cloud, you can future-proof your data architecture and unlock data access, massive scalability, high data durability and availability, and stream processing and analytics use cases.

You can get started directly in the cloud console or take advantage of integrated billing with your cloud service provider by signing up in the AWS, Google CloudGoogle Cloud or Microsoft Azure marketplace. After you sign up, use the Quick Start Guide to get familiar with using the web UI or Confluent CLI to manage clusters and topics.

How is Confluent Cloud different from open source Kafka?

Apache Kafka® is a distributed streaming engine that powers high-throughput, fault tolerant, and highly scalable real-time data pipelines, stream processing, and event-driven data integration. In contrast, Confluent is a complete data streaming platform that goes beyond Kafka to offer enterprise-grade capabilities for securing, connecting, governing, and processing data streams with cloud-native autoscaling, enterprise-grade security, and pre-built and fully managed integrations.

As the fully managed deployment of our platform, Confluent Cloud is powered by a cloud-native Kafka service, fully rebuilt for seamless scalability and hybrid cloud integration. See a complete comparison of Confluent vs. Apache Kafka or learn more about Kora, our cloud-native Kafka engine.

What features does Confluent Cloud include?

Confluent Cloud includes:

- Fully managed Kafka clusters (Basic, Standard, Enterprise, Freight) that offer elastic scalability, infinite storage, guaranteed resiliency (with 99/99% uptime SLA for multi-AZ clusters, low latency, as well as Dedicated clusters for workloads that require pre-provisioned resources

- Data replication capabilities for data migration and disaster recovery with Confluent Replicator and Cluster Linking

- Enterprise-grade security features, including role based access control, encryption for data at rest and data in transit, audit logs, and private networking

- Metrics API for monitoring cluster performance, consumer lag, and other metrics

- Support for a wide range of client languages, including Java, Python, .NET, Go, Node.js, and CC++

- 120+ pre-built Kafka connectors and 90+ fully managed connectors, available on Confluent Hub

- Stream Governance, an advanced, fully managed suite of governance tooling, which includes Stream Lineage, Stream

- Confluent Cloud for Apache Flink®, a serverless stream processing service that allows you to enrich, join, and filter data and integrate AI/ML models with AI Model Inference

How does Confluent Cloud pricing work?

Confluent Cloud’s pricing is determined by the features used (i.e., stream, connect, govern, and process capabilities), the selected tier, and the specific task & its rate per processing unit, throughput, or environment. Monthly bills are determined by consumption of resources within your cloud organization.

With Confluent Cloud, you can make annual commitments to minimum spend. With commitments, discounts scale with your usage across the entire Confluent Cloud stick,including clusters, connectors, Stream Governance, stream processing, and technical support.