[Webinar] How to Implement Data Contracts: A Shift Left to First-Class Data Products | Register Now

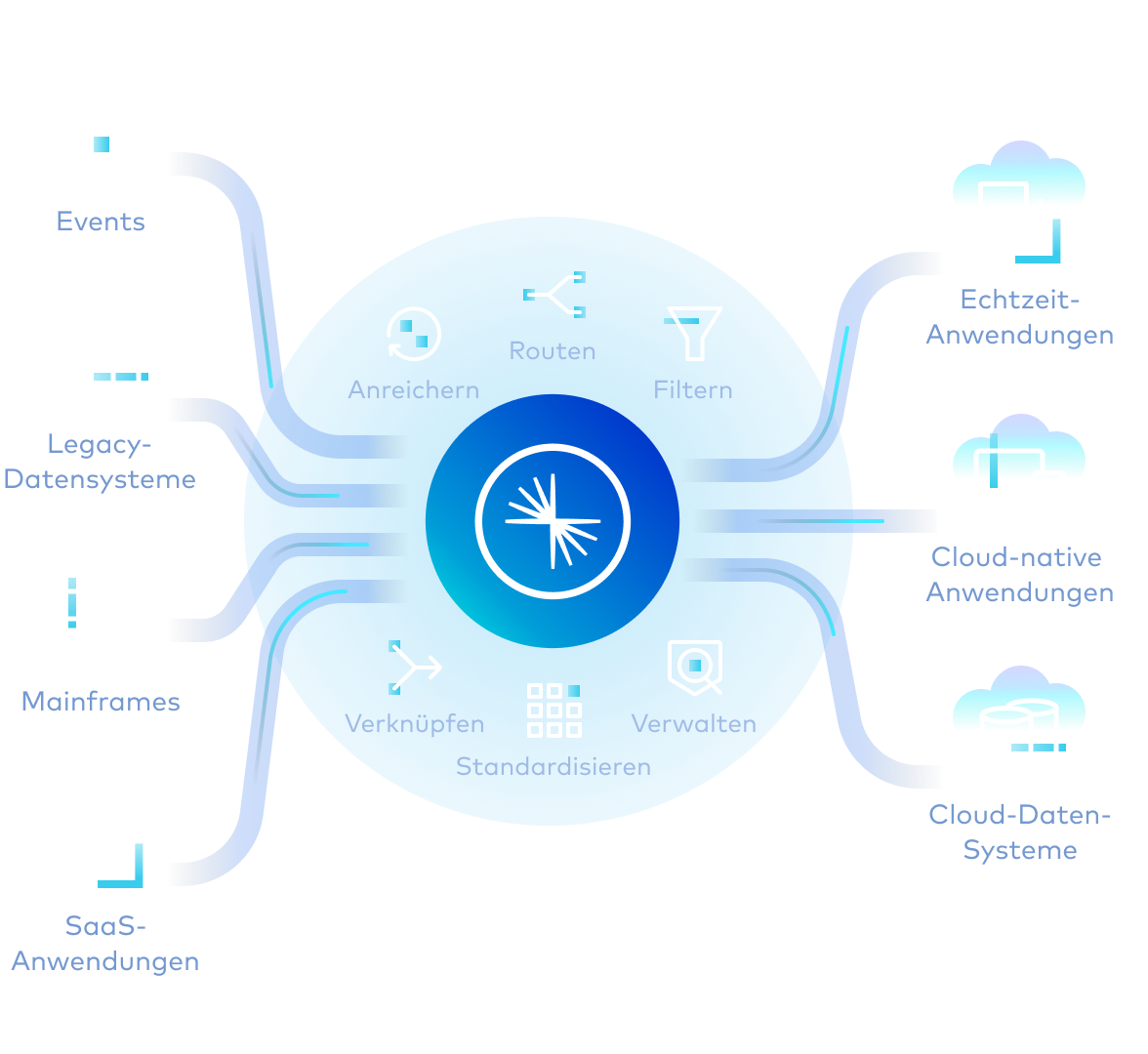

Daten-Streaming-Pipelines

Durch Daten zur richtigen Zeit am richtigen Ort und im richtigen Format können Produkte schneller und für viele Anwendungsfälle erstellt werden.

Daten-Pipelines richtig gemacht

Sofortige Entscheidungsfindung und agile Entwicklung mit unterbrechungsfreiem Streaming, fortlaufender Verarbeitung und verwaltetem Self-Service-Datenzugriff.

Streaming

Nutzung kontinuierlich fließender und dynamischer High-Fidelity-Echtzeitdaten für alle Anwendungsfälle

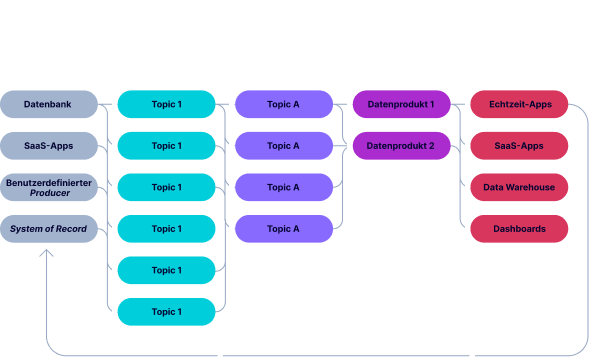

Dezentralisiert

Befähigung der Teams, die direkt mit den Daten arbeiten, zur Erstellung von Datenströmen und deren Weitergabe innerhalb des gesamten Unternehmens

Deklarativ

Separate Datenfluss- und Verarbeitungslogik zur Optimierung von Kosten und Leistung in großem Maßstab

Entwicklerorientiert

Einbringung von Softwareauslieferungspraktiken in Pipelines für agiles Experimentieren, Testen und Bereitstellen

Verwaltet

Schaffen eines Gleichgewichts zwischen Self-Service-Zugang und Sicherheits- und Compliance-Regeln durch durchgängige Regelungen

Warum Confluent

Durch den Aufbau moderner Datenflüsse werden die Wiederverwendbarkeit von Daten, die technische Flexibilität und die Zusammenarbeit gefördert, sodass mehr Teams gut aufbereitete Daten nutzen und deren Potenzial voll ausschöpfen können.

Überbrücken der Datenkluft

Unterstützung aller operativen, analytischen und SaaS-Anwendungsfälle durch hochwertige Echtzeit-Datenströme

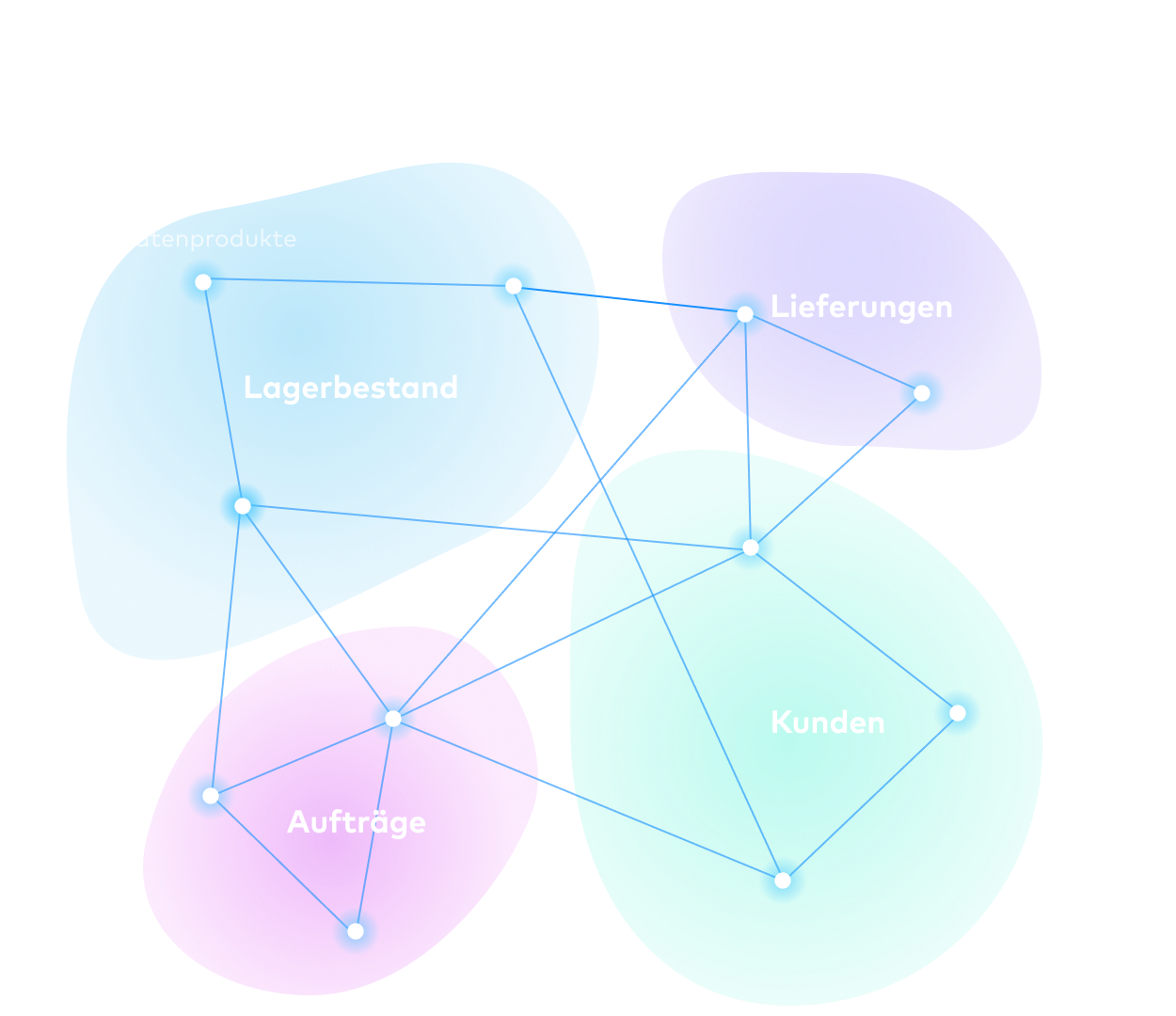

Verkürzung der Markteinführungszeit

Verwaltung von Datenverträgen und Unterstützung von Self-Service-Suche und -Discovery im Hinblick auf vertrauenswürdige Datenprodukte

Entwicklung mit Blick auf Leistung und Skalierbarkeit

Darstellung der Datenflusslogik und automatische Anpassung der Infrastruktur zur Verarbeitung von Daten in großem Maßstab

Agile Entwicklung

Einfache Iteration, Weiterentwicklung und Wiederverwendung von Datenflüssen mit DevOps-Toolchain-Integrationen und einer offenen Plattform

Aufrechterhaltung von Vertrauen und Compliance

Nachverfolgung des Verbleibs von Daten, des Weges dorthin und des Zugriffs auf die Daten mit durchgängiger Governance

Schnelle und einfache Schritte zur Erstellung von Daten-Streaming-Pipelines

Eine Datenpipeline kann innerhalb weniger Minuten eingerichtet werden. Nun ist es so leicht wie nie zuvor, Echtzeit-Datenströme einzurichten und Daten überall zu teilen.

1. Verbindung

Erstellen und Verwalten von Datenflüssen mit einer benutzerfreundlichen Benutzeroberfläche und vorgefertigten Connectors

2. Governance

Zentrale Verwaltung, Kennzeichnung, Prüfung und Anwendung von Richtlinien für vertrauenswürdige, hochwertige Datenströme

3. Anreicherung

Verwendung von SQL zum Kombinieren, Aggregieren, Bereinigen, Verarbeiten und Gestalten von Daten in Echtzeit

4. Entwicklung

Aufbereitung von gut formatierten, vertrauenswürdigen Datenprodukten für nachgelagerte Systeme und Anwendungen

5. Freigabe

Sichere Zusammenarbeit bei Live-Streams durch Self-Service-Daten-Discovery und -Freigabe