[Live Lab] Streaming 101: Hands-On with Kafka & Flink | Secure Your Spot

CONFLUENT INTELLIGENCE

Echtzeit-, kontextsensitive KI-Systeme entwickeln

Confluent Intelligence ermöglicht KI-Systemen, kontinuierlich aus historischen Daten zu lernen und in Echtzeit zu agieren. So können KI-Agenten, RAG (Retrieval Augmented Generation) und ML-Pipelines für KI erstellt sowie Kontext mit Apache Kafka® und Apache Flink® bereitgestellt werden.

Event-getriebene, auf Geschwindigkeit und Skalierbarkeit ausgelegte Agenten erstellen

Agenten mit Echtzeit-Kontext versorgen, um optimale Entscheidungen zu treffen

Präzise Entscheidungsfindung dank nativer ML-Funktionen beschleunigen

Was ist Confluent Intelligence?

Confluent Intelligence ist ein vollständig verwalteter Service in Confluent Cloud zum Aufbau von Echtzeit-, wiederholbaren und kontextreichen KI-Systemen, die von Kafka und Flink angetrieben werden. KI-Systeme, die auf LLMs basieren, müssen auf realen Daten beruhen und Live-Entscheidungen im Produktionsbetrieb unterstützen. Confluent Intelligence schließt diesen Kreislauf, indem es historische Auswertung, kontinuierliche Verarbeitung und Echtzeitbereitstellung kombiniert mit:

- Integrierten ML-Fähigkeiten für Anomalieerkennung, Betrugsprävention und Prognosen

- Streaming Agents, die nativ auf Kafka und Flink laufen, um Workflows zu automatisieren

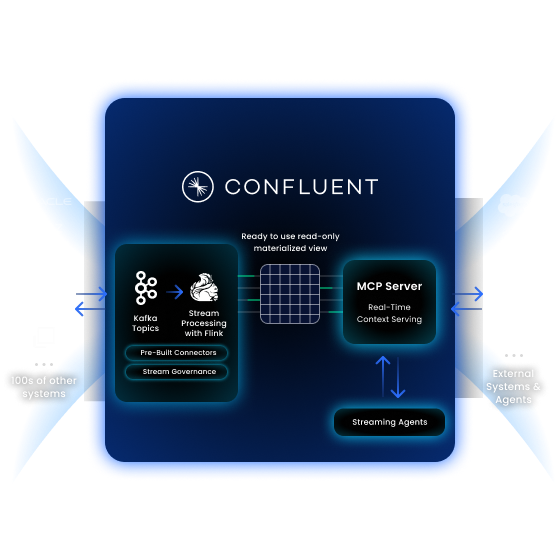

- Real-Time Context Engine zur Bereitstellung von zuverlässigem, strukturiertem Kontext für jede KI-App oder jeden Agenten über MCP

Da Confluent Intelligence von der Daten-Streaming-Plattform angetrieben wird, nutzt es dieselben verwalteten Echtzeitdaten, die für die KI genutzt werden — und liefert sichere, kontextbezogene und produktionsreife Informationen in jeder Größenordnung.

Einführung der Real-Time Context Engine

Unser Ansatz für Streaming + KI, angetrieben durch die Real-Time Context Engine

Ein Echtzeit-Backbone für KI mit Confluent + Google

Kombination von MCP und A2A zur Unterstützung von Multi-Agenten-Systemen

Wie KI-Agenten mit MCP betrieben werden können

Ein Tutorial über agentische KI mit Anthropic MCP, Claude LLM und Confluent

Always-On-Agenten im Stream integriert

Streaming Agents vereint Datenverarbeitung und KI-Workflows und ermöglicht die einfache Erstellung und Ausführung von Event-getriebenen Agenten direkt auf Flink. Mit Zugriff auf kontextualisierte Echtzeitdaten sind sie hervorragend geeignet für Enterprise-Workflows, um operative Events zu überwachen, sobald sie eintreten, und sofort fundierte Maßnahmen zu ergreifen.

Nahtlose Integrationen

Sicher und skalierbar mit jedem Modell, Tool oder Datensystem über einen Model Context Protocol (MCP)-Server verbinden, um umfassenden Echtzeit-Kontext zu erhalten

Kontextsensitive Automatisierung

Agenten können dynamisch mit Flink-Jobs auf angereicherten, verwalteten Datenströmen arbeiten – ohne Polling oder Verzögerungen.

Replay und Debugging

Die größten Lücken in KI-Systemen mit End-to-End-Observability schließen, um Tests, Debugging, Bewertungen, Audits und zuverlässige Wiederherstellungen nach Ausfällen durchzuführen – schneller und sicherer.

Echtzeit-RAG

Kontinuierlich aktuellen Kontext für RAG und semantische Suche bereitstellen, indem jedes Kafka-Topic in einen Stream von Vektoreinbettungen umgewandelt wird

Aktueller Kontext zur Unterstützung jeder KI-Entscheidung

Mit unserer Echtzeit-Kontext-Engine können über MCP strukturierte Live-Kontexte in Echtzeit aus angereicherten Unternehmensdaten an jedes KI-System gesendet werden – LangChain, Bedrock, Agentforce, Claude und mehr. Vollständig gemanaged auf Confluent Cloud, liefert sie verwaltete Echtzeit-Kontexte.

Niedrige Latenzen für jede KI-App oder jeden Agenten

Jeden KI-Agenten, Copiloten und jedes Modell überall mit strukturierten, aktuellen und relevanten Daten versorgen, anstatt mit veralteten Momentaufnahmen.

Kontinuierliche Synchronisierung mit vorgelagerten Daten und Systemen

Historische und Streaming-Daten vereinheitlichen, die automatisch aktualisiert werden, wenn sich die vorgelagerte Logik oder Eigenschaften ändern, um sicherzustellen, dass Entscheidungen den aktuellen Kontext widerspiegeln

Keine Infrastruktur zu verwalten

Komplexität beseitigen, zur vollen Konzentration auf den Aufbau von KI mit vollständig verwaltetem MCP und gleichzeitig von integrierter Authentifizierung, RBAC, Audit-Logging und Observability profitieren. Kein Kafka- oder Flink-Know-how erforderlich

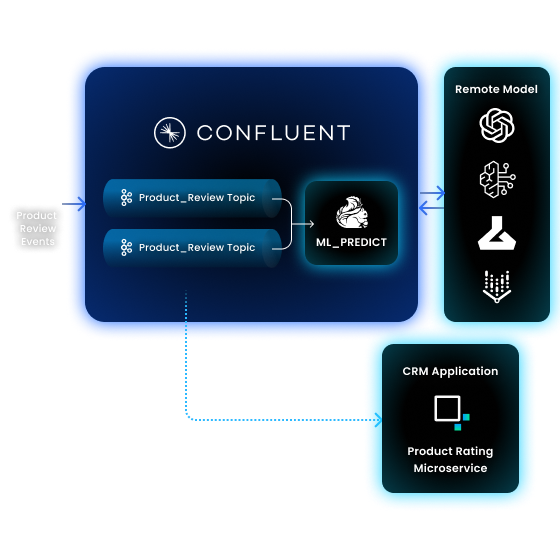

Maschinelles Lernen in Echtzeit

Leistungsstarke ML-Pipelines zur Betrugs- und Anomalieerkennung, für Prognosen, zur Sentiment-Analyse und mehr einsetzen, um KI-Workflows zu starten. Mit nativen Apache Flink-Funktionen können ML-Fähigkeiten direkt in Datenströme eingebettet, Workflows vereinfacht und präzise, umsetzbare Erkenntnisse gewonnen werden.

Anomalieerkennung

Unerwartete Abweichungen in Echtzeit erkennen, um die Datenqualität zu verbessern und schnellere Entscheidungen zu ermöglichen

Forecasting

Echtzeitanalysen durchführen und umsetzbare Erkenntnisse aus den Streaming-Daten gewinnen, ohne Bedarf an umfassendem Data-Science-Know-how

ML-Vorverarbeitung

Merkmale umwandeln, um die Darstellung für nachgelagerte Verarbeitungsprozesse zu optimieren

Remote-KI/ML-Modelle aufrufen

Entwicklung und Bereitstellung von KI vereinfachen dank einer einheitlichen Plattform sowohl für die Datenverarbeitung als auch für KI/ML-Aufgaben

Confluent Intelligence lässt sich nahtlos in die eigene KI-Infrastruktur integrieren. Es kann über die wichtigsten Cloud-Provider bereitgestellt und mit den führenden Lösungen für Vektorsuche, Datenbanken und KI-Frameworks verbunden werden. Jetzt mithilfe unserer strategischen Partner und Systemintegratoren alle Echtzeit-KI-Initiativen beschleunigen.

„Die Plattform von Confluent ermöglicht es uns, Änderungen in Echtzeit zu streamen, so dass unsere KI-Tools immer die relevantesten und aktuellsten Informationen bereitstellen.“

„Daten-Streaming wird in Zukunft für Finanzdienstleistungsunternehmen von entscheidender Bedeutung sein – insbesondere bei Anwendungsfällen von KI/ML, bei denen die Fähigkeit, Daten zu streamen, Workflow-Automatisierung zu implementieren und Echtzeit-Prognosen zu erstellen, der Schlüssel zum Erfolg ist.“

„Jeder will KI – aber die Herausforderung besteht darin, qualitativ hochwertige Daten in Echtzeit zu übertragen. Die Daten-Streaming-Plattform von Confluent ermöglicht uns dies. Sie bildet die Grundlage, mit der unsere Daten in Bewegung gesetzt und dorthin gebracht werden, wo sie benötigt werden.“

„Gute KI braucht gute Daten. Confluent ist unsere zuverlässige Informationsquelle. Die Daten-Streaming-Plattform bietet Kontext und Orchestrierung für unsere KI-Agenten, um Workflows zu automatisieren und unsere Transformation zur Smart City voranzutreiben.“

Neue Entwickler erhalten Credits im Wert von 400 $ für die ersten 30 Tage – kein Kontakt zum Vertrieb erforderlich.

Confluent bietet alles Notwendige zum: – Entwickeln mit Client-Libraries für Sprachen wie Java und Python, Code-Beispielen, über 120 vorgefertigten Connectors und einer Visual Studio Code-Extension. – Lernen mit On-Demand-Kursen, Zertifizierungen und einer globalen Experten-Community. – Betreiben mithilfe einer CLI, IaC-Unterstützung für Terraform und Pulumi und OpenTelemetry-Observability.

Die Registrierung ist über das Cloud-Marketplace-Konto unten möglich oder direkt bei uns.

Confluent Cloud

Ein vollständig verwalteter cloud-nativer Service für Apache Kafka®

Confluent Intelligence | FAQs

What is Confluent Intelligence and how does it help build AI applications?

Confluent Intelligence is a fully managed service on Confluent Cloud, designed for building real-time, context-rich AI systems. It unifies the essential components for production AI—stream processing, state management, and context delivery—into a single stack. This allows developers to build and deploy event-driven, context-aware AI applications powered by Apache Kafka® and Flink® without the heavy operational burden of managing complex infrastructure.

How do "Streaming Agents" work within Confluent Intelligence?

Streaming Agents is a framework for building, testing, and deploying event-driven AI agents directly on your data streams using fully managed Flink and Kafka. Because these agents run as Flink jobs within the stream processing pipeline, they have access to the freshest, most accurate view of your business. This enables them to monitor events and take instant, informed actions as they happen, making them ideal for enterprise automation and real-time decision-making.

What makes Confluent Intelligence uniquely suited for real-time generative AI (GenAI) applications?

Confluent Intelligence is uniquely suited for GenAI because it solves the critical challenge of providing real-time, trustworthy context. It combines AI agents that can live in your data streams, a real-time context engine and native ML functions, allowing GenAI applications to access live, indexed data and building event-driven AI without requiring developers to write custom Kafka code or build complex data polling mechanisms.

Can I use my own machine learning models with Confluent Intelligence?

Yes. Confluent Intelligence allows you to execute sophisticated AI and machine learning pipelines. In addition to native Flink functions for anomaly detection and forecasting, it provides the capability to invoke remote AI/ML models. This simplifies the development and deployment of your AI applications by providing a unified platform for both data processing and your custom AI/ML tasks.

How does Confluent Intelligence help create and use embeddings for AI?

Confluent Intelligence streamlines the process of creating vector embeddings for your AI applications. You can choose your preferred embedding model and transform a text column within a Kafka topic into a continuous stream of vector embeddings. This real-time embedding creation is essential for powering use cases like Retrieval-Augmented Generation (RAG) and semantic search in your GenAI applications.

What are some real-world use cases for AI Agents built on Confluent?

The platform is designed for a variety of enterprise use cases, including:

- Real-time Copilots: Building intelligent assistants that use current, contextual data from over 120 sources to provide more accurate decision-making.

- Workflow Automation: Orchestrating complex business processes with AI Agents that run continuously, with humans kept in the loop for critical decisions.

- Real-time Fraud Detection: Using integrated anomaly detection on live transaction streams to identify and block fraudulent activity in milliseconds.

What is the Model Context Protocol (MCP) and why is it important for AI Agents?

Model Context Protocol (MCP) is an open standard that provides a universal way for AI models to connect to data sources and tools. MCP is transformative for agentic AI because it enables you to provide agents with improved context and give them access to a rich toolkit of capabilities by simply connecting it to relevant MCP servers.