Ahorra un 25 % (o incluso más) en tus costes de Kafka | Acepta el reto del ahorro con Kafka de Confluent

STREAM GOVERNANCE A NIVEL ENTERPRISE

Descubre, comprende y confía en tus datos

Stream Governance ofrece una mayor visibilidad y control sobre la estructura, la calidad y el flujo de datos en tus aplicaciones, procesos de análisis y modelos de IA.

Acertus reduce el TCO y garantiza la calidad de los datos

Vimeo acelera la selección de productos de datos a unas horas, en lugar de días

SecurityScorecard protege los datos más importantes del negocio

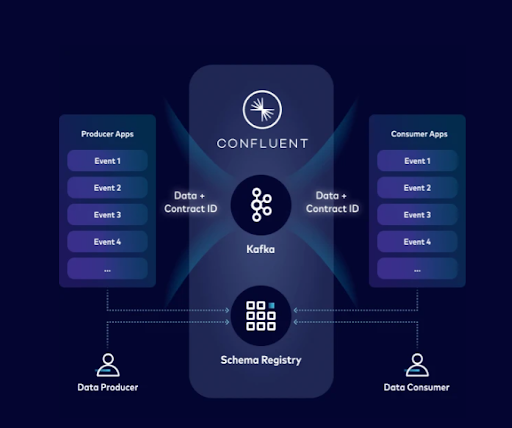

Stream Governance unifica la calidad, el descubrimiento y el linaje de los datos. Puedes crear productos de datos en tiempo real definiendo contratos de datos una sola vez y aplicándolos a medida que se generan los datos, en lugar de aplicarlos después de procesar cada lote.

Cómo proteger datos personales en Apache Kafka® con Schema Registry y contratos de datos

Descubre cómo proteger los datos más sensibles

Garantiza la calidad de los datos en la fuente, en lugar de tras procesarlos por lotes

Stream Quality evita que entren datos incorrectos en los streams de datos.

Gestiona y facilita que se cumplan los contratos de datos —esquemas, metadatos y normas de calidad— entre producers y consumers dentro de tu red privada gracias a sus funciones únicas:

Schema Registry

Define y aplica estándares universales para todos tus topics de streaming de datos en un repositorio versionado.

Contratos de datos

Aplica reglas semánticas y lógica empresarial en tus streams de datos

Schema Validation

Los brokers verifican que los mensajes usen esquemas válidos cuando se asignan a un topic específico.

Schema Linking

Sincroniza esquemas en entornos de la nube e híbridos en tiempo real.

Cifrado a nivel de campo del lado del cliente (CSFLE)

Protege tus datos más sensibles cifrando campos específicos dentro de los mensajes a nivel del cliente.

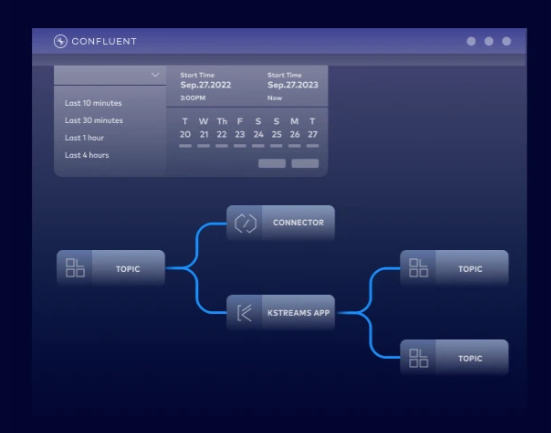

Supervisa los flujos de datos y resuelve problemas en minutos

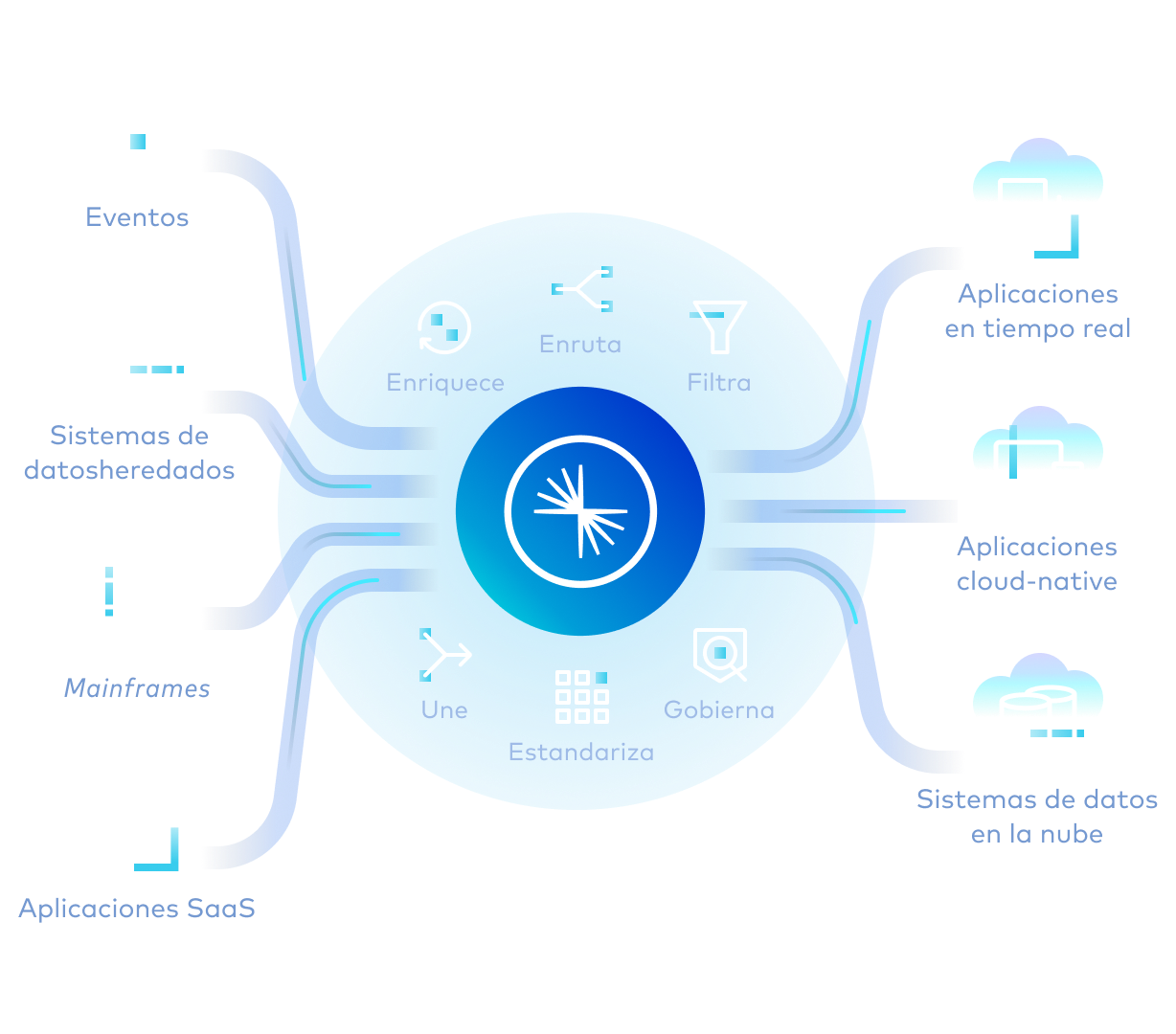

Todos los producers autorizados —sea cual sea la cantidad— pueden escribir eventos en un registro compartido, y los consumers pueden leer esos eventos de forma independiente y en paralelo. Puedes añadir, evolucionar, recuperar y escalar producers o consumers, sin dependencias.

Confluent integra tus sistemas heredados y modernos:

Bibliotecas de cliente

Despliega una aplicación de cliente de muestra en minutos: podrás usar tu lenguaje preferido

Conectores preconstruidos

Ahorra entre 3 y 6 meses de trabajo de ingeniería para diseñar, desarrollar y probar cada conector

Custom Connectors

Crea tus propias integraciones y déjanos gestionar la infraestructura de Connect

Acelera el time-to-market con acceso en autoservicio

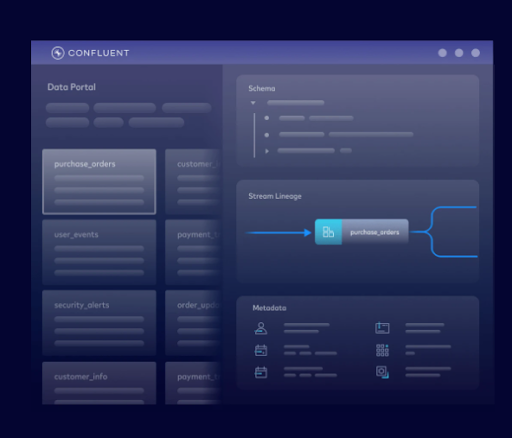

Stream Catalog organiza los topics de streaming de datos como productos de datos y permite cualquier sistema operativo, de análisis o de IA pueda acceder a ellos.

Etiquetado de metadatos

Enriquece los topics con información del negocio sobre equipos, servicios, casos de uso, sistemas y mucho más.

Data Portal

Permite que los usuarios finales busquen, consulten, descubran, soliciten acceso y vean cada producto de datos a través de una interfaz de usuario.

Enriquecimiento de datos

Consume y enriquece streams de datos, ejecuta consultas y crea pipelines de datos en streaming directamente en la interfaz de usuario

Acceso programático

Busca, crea y etiqueta topics a través de una API REST basada en Apache Atlas y una API GraphQL.

Prepara tus datos para el futuro en cualquier entorno o arquitectura

Estas son algunas de las funciones que te ayudarán a responder a los cambios en los requisitos de tu negocio sin afectar a las cargas de trabajo de aplicaciones, análisis o IA:

Evolución segura de los esquemas

Añade nuevos campos, modifica las estructuras de datos o actualiza los formatos manteniendo la compatibilidad con los informes, paneles de control y modelos de machine learning que ya utilizas.

Verifica la compatibilidad automáticamente

Valida los cambios de esquema antes de desplegarlos para evitar que se interrumpan las aplicaciones de análisis y las pipelines de IA.

Rutas de migración flexibles

Elige el tipo de compatibilidad (hacia atrás, hacia adelante o total) según los requisitos de tus actualizaciones y las restricciones organizativas.

ACERTUS utiliza Schema Registry para facilitar la creación y edición de contratos de pedidos sin tener que reescribir el código. Los cambios en los esquemas y los datos de los topics se anotan en tiempo real: de este modo, cuando los usuarios de datos encuentren los datos que buscan, pueden estar seguros de que son precisos y fiables.

Confluent garantiza la calidad y seguridad de los datos con Stream Governance, y permite a Vimeo escalar y compartir productos de datos de forma segura en todo su negocio.

«Es increíble lo que se puede conseguir cuando no tenemos que preocuparnos por cómo hay que hacer cada cosa al más mínimo detalle. Podemos confiar en que Confluent nos ofrecerá una plataforma segura y robusta para Kafka, además de muchísimas funciones valiosas en materia de seguridad, gobernanza y conectores».

Los nuevos desarrolladores reciben 400 dólares en créditos para gastar durante los primeros 30 días. Puedes probarlo sin largas conversaciones con ningún equipo de ventas.

Estos son algunos ejemplos de lo que puedes conseguir con Confluent:

- Desarrollar con bibliotecas cliente para lenguajes como Java y Python, código de ejemplo, más de 120 conectores preconstruidos y una extensión de Visual Studio Code.

- Aprender con cursos disponibles a la carta, certificaciones y una comunidad mundial de expertos.

- Operar desde una interfaz de línea de comandos (CLI), con compatibilidad con IaC para Terraform y Pulumi, y observabilidad de OpenTelemetry.

Puedes registrarte desde la cuenta de tu marketplace en la nube preferido o crear una cuenta de Confluent gratis.

Confluent Cloud

Servicio cloud-native totalmente gestionado para Apache Kafka®

Stream Governance With Confluent | FAQS

What is Stream Governance?

Stream Governance is a suite of fully managed tools that help you ensure data quality, discover data, and securely share data streams. It includes components like Schema Registry for data contracts, Stream Catalog for data discovery, and Stream Lineage for visualizing data flows.

Why is Stream Governance important for Apache Kafka?

As Kafka usage scales, managing thousands of topics and ensuring data quality becomes a major challenge. Governance provides the necessary guardrails to prevent data chaos, ensuring that the data flowing through Kafka is trustworthy, discoverable, and secure. This makes it possible to democratize data access safely.

What components are included in Confluent’s Stream Governance?

While open source provides basic components like Schema Registry, Confluent offers a complete, fully managed, and integrated suite. Stream Governance combines data quality, catalog, and lineage into a single solution that is deeply integrated with the Confluent Cloud platform, including advanced features like a Data Portal, graphical lineage, and enterprise-grade SLAs.

How is Confluent’s approach different from open source Kafka governance?

Yes. Confluent Schema Registry supports Avro, Protobuf, and JSON Schema, giving you the flexibility to use the data formats that best suit your needs.

Does Stream Governance support industry standards like Avro and Protobuf?

Yes, Confluent Stream Governance provides robust support for industry-standard data serialization formats through its integrated Schema Registry.

Schema Registry centrally stores and manages schemas for your Kafka topics, supporting the following formats: Apache Avro, Protobuf, JSON Schema.

This ensures that all data produced to a Kafka topic adheres to a predefined structure. When a producer sends a message, it serializes the data according to the registered schema, which typically converts it into a compact binary format and embeds a unique schema ID. When a consumer reads the message, it uses that ID to retrieve the correct schema from the registry and accurately deserialize the data back into a structured format. This process not only enforces data quality and consistency but also enables safe schema evolution over time.

Can I use Stream Governance on-premises?

The complete Stream Governance suite, including the Data Portal and interactive Stream Lineage, is exclusive to Confluent Cloud. However, core components like Schema Registry are available as part of the self-managed Confluent Platform.

Is Stream Governance suitable for regulated industries?

Yes. Stream Governance is suitable for regulated industries and provides the tools you need to ensure data security and compliance with industry and regional regulations. Its Stream Lineage features help with audits, allowing you to use schema enforcement and data quality rules to ensure data integrity. Across the fully managed data streaming platform, Confluent Cloud also holds numerous industry certifications like PCI, HIPAA, and SOC 2.

How can I get started with Stream Governance?

You can get started with Stream Governance by signing up for a free trial of Confluent Cloud. New users receive $400 in cloud credit to apply to any of the data streaming, integration, governance, and stream processing capabilities on the data streaming platform, allowing you try Stream Governance features firsthand.

We also recommended exploring key Stream Governance concepts in Confluent documentation, as well as following the Confluent Cloud Quick Start, which takes you through how to deploy your first cluster, product and consume messages, and inspect them with Stream Lineage.