Apache Kafka®️ 비용 절감 방법 및 최적의 비용 설계 안내 웨비나 | 자세히 알아보려면 지금 등록하세요

스트리밍 데이터 파이프라인

스트리밍 데이터 파이프라인을 사용하면 지속적인 데이터 수집, 처리와 함께 데이터가 실시간으로 생성되자마자 소스에서 대상으로 옮기는 것이 가능합니다. 스트리밍 ETL 및 실시간 데이터 흐름이라고도 하는 이 기술은 수많은 산업 분야에서 데이터 전송, 실시간 인사이트 및 분석을 가속화하기 위해 데이터베이스를 스트리밍 수집과 처리를 위한 라이브 피드로 전환하는 데 사용됩니다.

Apache Kafka의 개발자들이 만든 Confluent의 데이터 스트리밍 플랫폼은 120건 이상의 ��사전 구축된 통합, 보안, 거버넌스 및 수많은 사용 사례로 실시간 데이터 파이프라인을 자동화합니다.

What Are Streaming Data Pipelines?

- Mobile banking apps

- GPS apps that recommend driving routes based on live traffic information

- Smartwatches that track steps and heart rate

- Personalized real-time recommendations in shopping or entertainment apps

- Sensors in a factory where temperatures or other conditions need to be monitored to prevent safety incidents

실시간. 규모에 맞게 지원.

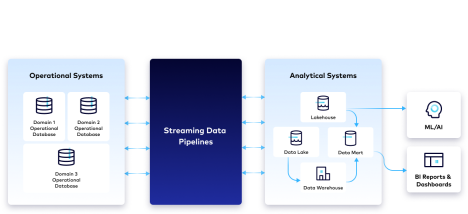

스트리밍 데이터 파이프라인은 이기종 데이터 소스의 다양한 데이터 형식을 지원하고 초당 수백만 건의 이벤트 규모로 작동합니다. 이들은 환경 전반에서 데이터를 스트리밍하여 데이터 사일로를 해소하고 조직을 위해 실시간 데이터 흐름을 제공하며, 다음 두 가지 유형의 시스템을 연결하는 데 자주 사용됩니다.

- 온프레미스 또는 클라우드일 수 있는 운영 데이터베이스에 서로 다른 형식의 데이터가 저장되어 있는 운영 시스템.

- 데이터 웨어하우스 또는 데이터 레이크에 데이터를 채우고 실시간 분석, 보고, BI 대시보드 및 기타 데이터 과학 이니셔티브에 사용되는 분석 시스템.

스트리밍 데이터 파이프라인을 선택해야 하는 이유

실시간 데이터 흐름

스트리밍 데이터 파이프라인은 데이터가 실시간으로 발생할 때 소스에서 대상 시스템으로 데이터를 옮기고 변환함으로써 가장 정확한 최신 데이터를 즉시 사용할 수 있는 형식으로 제공하여 개발 민첩성을 높이고, 조직이 더 많은 정보를 바탕으로 보다 선제적인 결정을 내리는 데 도움이 되는 인사이트를 발견할 수 있게 해줍니다.실시간 이벤트에 지능적으로 대응할 수 있는 역량은 위험을 낮추고, 더 많은 수익 또는 비용 절감을 창출하며, 더욱 개인화된 고객 경험을 제공합니다.

실시간 스트림 처리

스트림 처리는 특히 데이터 지연 시간 측면에서 일괄 처리에 비해 상당한 이점이 있습니다. 일괄 처리 기반의 ETL 파이프라인은 정기적으로(주로 밤마다) 일괄 처리로 데이터를 수집하고 변환합니다. 반면, 스트림 처리를 사용하면 데이터가 생성되는 동안 대상 시스템으로 전송되는 도중에 실시간 데이터를 지속적으로 변환할 수 있습니다. 이를 통해 지연 시간을 최소화하고 스트리밍 데이터를 통해 실시간 사기 탐지와 같은 사용 사례를 강화할 수 있습니다. 다양한 데이터 처리 유형에 대해 자세히 알아보려면 일괄 처리와 스트림 처리 비교를 참조하세요.

민첩한 파이프라인 개발

개별 데이터 파이프라인을 수작업으로 코딩하지 않아도 되므로, 조직은 고장과 수정에 소요되는 시간을 줄이고 데이터 스트림을 혁신적으로 사용하고 변화하는 비즈니스 요구 사항에 맞게 데이터를 조정하는 데 더 많은 시간을 할애할 수 있습니다. 기술 부채 및 필요한 유지 관리가 줄어들어 팀은 기업 전체에서 데이터를 보다 효율적으로 관리할 수 있습니다.

확장 가능한 내결함성 클라우드 아키텍처

클라우드의 자동 확장과 탄력성을 통해 스트리밍 데이터 소비자는 인프라 관리가 아닌 데이터 사용에 집중할 수 있습니다. 이벤트가 지속적으로 흐르기 때문에 기본으로 제공되는 내결함성은 데이터 손실, 기회 상실 및 응답 시간 지연으로부터 조직을 보호합니다.

스트리밍 데이터 파이프라인 작동 방식

스트리밍 데이터 파이프라인은 생성되는 원시 데이터를 수집하고, 정리하고, 조직의 필요에 맞게 결과를 사용자 정의하는 등 일련의 단계를 지속적으로 실행합니다.

수집

실시간 데이터는 다양한 형식의 온프레미스 및 클라우드 기반 데이터 소스(예: 애플리케이션, ��데이터베이스, IoT 센서)에서 수집됩니다.

스트리밍 처리

데이터 조작, 정리, 변환 및 준비 과정은 파이프라인에서 사용할 수 없는 데이터를 제거하고 모니터링, 분석 및 기타 다운스트림에서 사용할 수 있도록 데이터를 준비합니다.

스키마 표준화

스트리밍 데이터를 준비하고 분석하려면 이를 데이터가 어떻게 구성되는지를 결정하고 파악하는 가이드인 표준 스키마로 일관되게 구조화해야 합니다. 표준 스키마를 준수하면 운영 복잡성을 줄이면서 확장 가능한 데이터 호환성을 보장할 수 있습니다.

스트림 모니터링

연속 이벤트를 생성하는 시스템을 더 잘 파악하기 위해 대부분의 조직에서는 이벤트 스트림에 관찰 가능성과 모니터링을 적용합니다. 스트림에 어떤 일이 일어나고 있는지(예: 시간이 지남에 따라 얼마나 많은 메시지가 생성되거나 소비되는지)를 볼 수 있는 기능은 스트림의 적절한 작동과 데이터 손실 없는 실시간 데이터 전송을 보장합니다.

메시지 브로커

메시지 브로커는 스트리밍 데이터 파이프라인 전체에서 데이터 제공과 전송을 처리하여 정확히 한 번만 처리되도록 보장하고 데이터의 무결성과 계보를 유지합니다.

프로비저닝

적시에 과거 데이터에 동시에 액세스해야 하는 다양한 대상 목적지와 다운스트림 소비자가 데이터를 쉽게 사용할 수 있습니다. 이러한 요구 사항을 충족하기 위해 많은 아키텍처에는 데이터 레이크, 데이터 웨어하우스, 메시지 브로커 자체에 데이터 저장소가 결합되어 있습니다.

최신 스트리밍 데이터 파이프라인 구축을 위한 5가지 원칙

1. 스트리밍

주기적으로 충실도가 낮은 스냅샷을 외부 리포지토리로 푸시하는 대신 데이터 스트림과 스트리밍 플랫폼을 사용하여 조직 내에서 재사용 가능한 데이터의 실시간 및 높은 충실도의 이벤트 수준 리포지토리를 유지하세요. 스키마를 생산자와 소비자 간의 데이터 계약으로 사용하여 데이터 호환성을 보장하세요.

2. 탈중앙화(분산)

데이터와 가장 가까운 팀에서 재사용할 수 있는 데이터 스트림을 생성하고 공유할 수 있도록 도메인 중심의 탈중앙화 데이터 소유권을 지원합니다. 전체 비즈니스에 걸쳐 데이터 스트림을 쉽게 게시하고 구독할 수 있도록 셀��프 서비스 데이터로 작업하는 팀의 역량을 강화합니다.

3. 선언형

SQL과 같은 선언형 언어를 활용하여 데이터의 논리적 흐름(데이터가 어디에서 오고 어디로 가는지)을 지정하여 로우 레벨의 운영 세부 사항 없이도 인프라가 데이터 규모의 변화를 자동으로 처리할 수 있습니다.

4. 개발자 중심

민첩한 개발과 CI/CD 관행을 파이프라인에 도입하여 팀이 다양한 환경에 개발, 테스트, 배포하고 독립적으로 버전을 관리할 수 있는 모듈식의 재사용 가능한 데이터 흐름을 구축할 수 있습니다. 시각적 IDE(통합된 개발 환경)와 코드 편집기를 모두 지원하는 도구를 사용하여 다양한 기술을 가진 팀원이 파이프라인에서 협업할 수 있도록 지원합니다. 이는 비개발자용으로 제작되는 경향이 있는 기존 ETL 도구와는 다릅니다.

5. 관리형

지속적인 데이터 관찰 가능성, 보안, 정책 관리, 규정 준수를 위한 탈중앙화 표준 간에 균형을 유지하면서 직관적인 검색, 발견, 계보를 통해 개발자와 엔지니어가 더 빠르게 혁신할 수 있도록 가시성과 투명성, 호환성을 제공합니다.

사용 사례 예시

클라우드로의 마이그레이션

애플리케이션 개발 작업을 마이그레이션하거나 현대화하고 클라우드-네이티브 도구를 활용하기 위해 스트리밍 데이터 파이프라인을 사용하면 온프레미스 및 멀티클라우드 데이터베이스를 실시간으로 연결하고 동기화할 수 있습니다. 이벤트를 처리하고 다른 스트림으로 보강하여 새로운 애플리케이션을 강화하고 레거시 데이터베이스 유지관리와 TCO를 절감할 수 있습니다. 실시간으로 사기를 탐지하기 위해 스트림 처리를 사용하며 Oracle CDC 커넥터가 레거시 데이터베이스에서 MongoDB와 같은 클라우드 네이티브 데이터베이스로 변경 사항을 스트리밍하는 데모를 시청하세요.

실시간 분석

스트리밍 데이터 파이프라인은 기업이 온프레미스 시스템에서 클라우드 데이터 웨어하우스로 데이터를 스트리밍하여 실시간 분석, ML 모델링, 보고, BI 대시보드 생성을 통해 가치 있는 인사이트를 도출할 수 있도록 지원합니다. 워크로드를 클라우드로 옮기면 컴퓨팅과 스토리지의 유연성, 민첩성, 비용 효율성이 향상됩니다. 다음 데모에서 PostgreSQL CDC를 사용하여 고객 데이터를 스트리밍하고, 스트림 처리를 사용하여 해당 데이터를 실시간으로 처리하고, Snowflake 커넥터를 사용하여 실시간 데이터 웨어하우징과 후속 분석 및 보고를 수행하는 방법을 살펴보세요.

SIEM 최적화

스트리밍 데이터 파이프라인은 상황을 보다 잘 인식하는 데 필요한 풍부한 컨텍스트 데이터를 제공하고, 위협 탐지를 자동화 및 조율하며, 오탐지를 줄이고, 위협 및 사이버 공격에 대한 선제적 대응 태세를 갖출 수 있도록 지원합니다. 이 페이지를 방문하여, 데이터(예: 로그, 네트워크 데이터, 텔레메트리 및 센서 데이터, 실시간 이벤트)를 통합, 분류 및 보강하여 팀이 실시간 모니터링 및 보안 포렌식을 위해 적시에 올바른 데이터를 확보할 수 있는 방법에 대해 자세히 알아보세요.

메인프레임 데이터 액세스

스트리밍 데이터 파이프라인은 중요한 기록 시스템 데이터에 대한 액세스를 해제하여 다른 데이터와 결합된 메인프레임 데이터에 실시간으로 액세스하여 사일로를 줄이고 새로운 애플리케이션을 강화하며, 여러 시스템에서 데이터 이식성을 높이고, MIPS 및 네트워킹 비용을 절감할 수 있습니다. 자세한 내용은 이곳에서 확인하세요.

Confluent를 선택해야 하는 이유

소스에서 대상 시스템으로 데이터를 직접 파이핑하면 확장이 불가능하고 비용 효율적인 방법으로 보호 및 유지 관리하기가 어려운 지점 간 연결이 생성됩니다. Confluent의 완전 관리형 Apache Kafka는 데이터 통합 및 확장 가능한 스트리밍 데이터 파이프라인 구축에 필요한 중추 역할을 하는 데이터 스트리밍 플랫폼입니다. Confluent를 사용하면 데이터 생산자와 소비자를 분리하고 이기종 시스템을 서로 연결하는 프로세스를 추상화할 수 있습니다.

Confluent는 120개 이상의 사전 구축된 소스 및 싱크 커넥터를 제공하여 하이브리드 및 멀티클라우드 환경에서 다양한 시스템 간에 데이터를 통합하고 스트리밍할 수 있도록 지원합니다. 팀이 필요할 때 언제 어디서나 셀프 서비스 데이터를 제공하는 완전 관리형 커넥터를 배포하여 6개월에서 몇 년이 걸리는 엔지니어링 시간을 절약하고 운영 오버헤드를 줄이세요. 또한, Flink를 통해 실시간으로 데이터 스트림을 처리 및 변환하고 Stream Governance를 통해 데이터 품질과 규정 준수를 보장할 수 있습니다. Confluent의 Stream Designer는 코드가 필요 없는 시각적 UI로서 스트리밍 데이터 파이프라인을 몇 분 만에 구축, 테스트 및 배포할 수 있습니다.