[Webinaire] Des exercices d'évacuation incendie à la résilience sans perte | S'inscrire

TRAITEMENT SANS SERVEUR Stream Processing

Créez instantanément des pipelines de données en temps réel

Combinez le streaming de données et le traitement des flux pour construire des pipelines de données qui transforment les événements commerciaux en produits de données frais, enrichis et prêts à l'emploi.

Unifiez Apache Kafka® et Apache Flink®

Intégration en un clic pour un traitement de flux fluideExécutez vos charges de travail partout.

Support multicloud dans plus de 50 régions sur AWS, Microsoft Azure et Google CloudConstruisez avec un ensemble d'outils familiers

Exploitez vos compétences existantes avec la prise en charge de SQL, Python et Java.Cessez de lutter contre la complexité opérationnelle liée à la gestion de systèmes open source séparés et complexes, ainsi qu'à l'assemblage d'un écosystème fragile d'outils. Créez, déployez et développez plutôt des pipelines de données fiables en temps réel qui éliminent les silos de données en utilisant des langages familiers.

Confluent Cloud est la seule plateforme serverless entièrement gérée qui combine les normes du secteur pour les données de streaming et le traitement des flux, et vous permet d'automatiser la gestion de l'infrastructure et de sécuriser les pipelines, du développement à la production. Explorez ce que vous pouvez accomplir en vous concentrant sur la création de valeur grâce à de puissantes capacités d’IA et d’analyse en temps réel, plutôt que sur la gestion des clusters.

Suivez un cours d'introduction à Apache Flink

Je me lance

Créez des pipelines CDC avec Apache Flink sur Confluent

Découvrez commentIntégration transparente entre Kafka et Flink

Simplifiez l'intégration en connectant Apache Kafka® et Apache Flink® grâce à une intégration en un clic sur Confluent, où les données sont considérées comme un produit réutilisable de première classe.

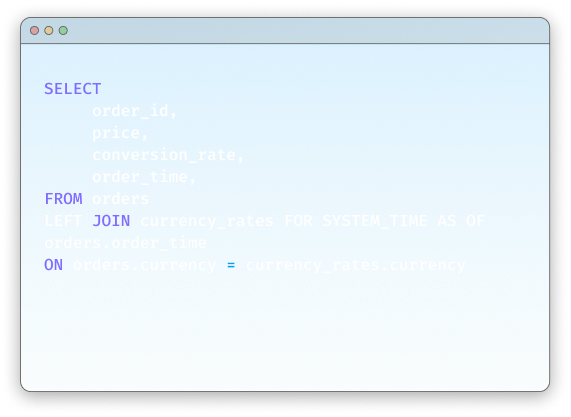

Les topics Kafka apparaissent automatiquement sous forme de tables Flink interrogeables avec des schémas g�érés par le Schema Registry, ce qui permet de réutiliser immédiatement les données traitées.

Intégration en un clic

Les topics et schémas Kafka sont toujours synchronisés avec Flink.

Streaming cloud-native

La norme cloud-native entièrement gérée pour Apache Kafka®

Apache Flink® cloud-native

La référence open source pour le traitement des flux

Prise en charge native pour la gestion des schémas

Schema Registry fournit un référentiel centralisé pour la gestion et la validation des schémas pour les données des messages d’un topic.

Simplifiez le traitement de flux avec état

Exploitez la puissance de Flink, la norme industrielle de référence pour le traitement des flux événementiels complexes et avec état.

Utilisez les normes ANSI SQL, Python ou Java pour réaliser des traitements d'événements complexes, des agrégations en temps réel et des transformations avec état, avec une prise en charge prête à l'emploi de la tolérance aux pannes, de la sémantique « exactly once » et des stratégies de filigrane par défaut.

« Exactly-once » simplifié

Assurez un traitement « exactly-once » facilement avec Confluent Cloud.

Créez avec ANSI SQL.

Créez des pipelines de traitement des flux avec un SQL familier

Tirez parti de Python

Créez facilement des pipelines de traitement des flux avec Python

Construisez avec Java

Créez des applications de streaming en utilisant Java

Offrez de la valeur plus rapidement avec une plateforme entièrement gérée

Concentrez-vous sur la création de produits de données, pas sur la gestion de l'infrastructure, grâce à une expérience sans serveur.

L'autoscaling élastique, la tarification à l'usage et les limites de calcul équilibrent les performances et les coûts. La flexibilité d'une interface utilisateur basée sur un navigateur, d'une interface en ligne de commande ou d'une extension VS Code, associée à des outils de surveillance intégrés tels que la stream lineage, accélère le processus de développement, de l'exploration à la mise en production.

Concentrez-vous sur le code

Laissez Confluent Code gérer tout le reste grâce à notre offre Flink cloud-native et sans serveur.

Espaces de travail Flink SQL

L'option principale, accessible via navigateur, pour utiliser SQL afin d'interagir avec vos données dans Confluent Cloud

Interface de ligne de commande Confluent

Gérer les états et les pools de calcul via la CLI

Extension VS Code

Boostez votre productivité grâce à l'extension VS Code

Créer dans un monde axé sur l’IA

Créez des systèmes d'IA/ML réactifs en temps réel et des agents axés sur les événements.

Préparez les données pour l'inférence en temps réel grâce à des fonctionnalités telles que l'intégration, la prévision et l'inférence, tout en intégrant de manière transparente des modèles externes, des LLMs, des outils et des cadres. Simplifiez votre stack IA pour passer de l’intégration à la génération de valeur par l’IA.

Intégration en temps réel

Générez des embeddings vectoriels sur vos données au sein de pipelines de données de streaming.

Prévisions en temps réel

Prévisions en temps réel à mesure que les événements traversent vos pipelines de streaming.

Inférence en temps réel

Exécutez des inférences sur les événements de votre flux

Appel d'outil

Support OOTB pour l'appel d'outils avec MCP

« Le traitement de flux est une fonctionnalité essentielle pour identifier les risques de sécurité et s'en prémunir en temps réel. Grâce à l'offre Flink entièrement gérée de Confluent, nous pouvons accéder aux données issues des capteurs IoT, des caméras intelligentes et des analyses Wi-Fi, puis les agréger et les enrichir afin de réagir en temps réel aux menaces potentielles, comme les tentatives d'intrusion. Nous sommes en mesure de traiter les données des capteurs au moment où les événements se produisent, ce qui nous permet de détecter les incidents de sécurité et d'y réagir plus rapidement sans entraîner de charge opérationnelle supplémentaire. »

« Le traitement de flux est une fonctionnalité essentielle pour identifier les risques de sécurité et s'en prémunir en temps réel. Grâce à l'offre Flink entièrement gérée de Confluent, nous pouvons accéder aux données issues des capteurs IoT, des caméras intelligentes et des analyses Wi-Fi, puis les agréger et les enrichir afin de réagir en temps réel aux menaces potentielles, comme les tentatives d'intrusion. Nous sommes en mesure de traiter les données des capteurs au moment où les événements se produisent, ce qui nous permet de détecter les incidents de sécurité et d'y réagir plus rapidement sans entraîner de charge opérationnelle supplémentaire.

« Nous utilisons Apache Flink pour traiter nos données avant qu'elles n'atteignent Snowflake, afin d'éviter des coûts supplémentaires inutiles. Lorsque nous parlons d'un entrepôt de données, il s'agit de milliards de points de données regroupés dans une seule table, et le traitement de ces données après leur stockage est extrêmement coûteux. Vos données circulent désormais en continu dans Flink. Nous les traitons en blocs temporels au fur et à mesure qu'elles se déplacent dans le système. Vous pouvez avoir vos données principales dans un seul flux allant vers votre entrepôt de données, tout en les agrégeant et en les envoyant en aval vers une autre plateforme de stockage—c'est beaucoup plus rentable et efficace. »

« Avec Flink, nous avons maintenant la possibilité de passer au shift left et d'effectuer de nombreuses transformations et calculs précoces sur nos données avant qu'elles n'atteignent Snowflake. » « Cela optimisera nos coûts de traitement des données afin d'augmenter la quantité de données dont nous disposons. »

Les nouveaux développeurs reçoivent 400 $ de crédits à dépenser pendant leurs 30 premiers jours, sans avoir à passer par un représentant commercial.

Confluent vous offre les outils et ressources nécessaires pour :

- Construire : tirez parti de bibliothèques clientes pour des langages comme Java et Python, des exemples de code, plus de 120 connecteurs préconfigurés et une extension Visual Studio Code.

- Apprendre : profitez d'un accès à des cours à la demande, des certifications et une communauté mondiale d'experts.

- Exploiter : bénéficiez d'une CLI, de la prise en charge de l'IaC pour Terraform et Pulumi, et de l'observabilité OpenTelemetry.

Vous pouvez vous inscrire directement avec nous ou avec votre compte cloud marketplace ci-dessous.

Confluent Cloud

Un service cloud native entièrement géré basé sur Apache Kafka®

Comment commencer le traitement

Stream Processing With Confluent | FAQs

What is Apache Flink and why is it used for stream processing?

Apache Flink is the de facto open-source standard for stateful stream processing, designed to run computations over unbounded, continuous data streams. It's used for building real-time data pipelines and event-driven applications because it provides low-latency processing, high throughput, and exactly-once consistency guarantees, which are critical for trustworthy, mission-critical systems.

Do I need Apache Kafka to use Confluent's Flink service?

Yes. Confluent Cloud is designed as a unified data streaming platform where Apache Kafka and Apache Flink are seamlessly integrated. Data must be in a Confluent Cloud Kafka topic to be processed by Flink. This tight integration is a core benefit, as it removes the need for custom connectors and provides a single, governed source of truth for all real-time data. However, Confluent Platform enables use of Flink with a variety of sources outside Apache Kafka.

How is Confluent's serverless Flink different from open-source Apache Flink?

Confluent Cloud provides a fully managed, serverless Flink service that eliminates the significant operational complexity of deploying, scaling, and securing open-source Flink. While open-source Flink is a powerful engine, Confluent provides a complete data streaming platform around it, including zero-config integration with Kafka, an integrated Schema Registry, enterprise-grade security, and a usage-based pricing model, allowing teams to focus on logic, not infrastructure.

How can I control costs with Flink's usage-based pricing?

Confluent Cloud provides several tools for cost management. The pricing is pay-as-you-go, based on CFUs consumed per minute, so you only pay for what you use. You can set configurable, hard spending limits on your compute pools to prevent budget overruns and monitor usage through the Metrics API to optimize your queries for cost-efficiency.