Ahorra un 25 % (o incluso más) en tus costes de Kafka | Acepta el reto del ahorro con Kafka de Confluent

PROCESAMIENTO EN STREAMING SIN SERVIDOS

Crea pipelines de datos en tiempo real, al instante

Combina el streaming de datos y el procesamiento en streaming para crear pipelines de datos que conviertan los eventos empresariales en productos de datos actualizados, enriquecidos y listos para consumir.

Unifica Apache Kafka® y Apache Flink®

Una integración en un solo clic para optimizar el procesamiento en streamingEjecuta cargas de trabajo desde cualquier lugar

Soporte multi-cloud para más de 50 regiones en AWS, Microsoft Azure y Google CloudDesarrolla con tu conjunto de herramientas preferido

Aprovecha tus habilidades: puedes desarrollar con SQL, Python y JavaGestionar sistemas de código abierto separados y complejos —o unificar un ecosistema frágil de herramientas— conlleva una sobrecarga operativa muy importante. En lugar de lidiar con esos retos, puedes desarrollar, desplegar y escalar pipelines de datos fiables y en tiempo real que eliminen los silos de datos usando los lenguajes de programación que ya dominas.

Confluent Cloud es la única plataforma totalmente gestionada y sin servidor que combina los estándares del sector para los datos en streaming y el procesamiento en streaming. Además, te permite automatizar la gestión de infraestructuras y asegurar las pipelines de datos en todas sus fases: desde el desarrollo hasta la producción. Descubre todo lo que puedes crear cuando dedicas tus recursos a ofrecer valor a tus clientes —gracias a la funcionalidades de análisis en tiempo real e inteligencia artificial—, en lugar de a gestionar clusters.

Curso de introducción a Apache Flink

Empieza ahora

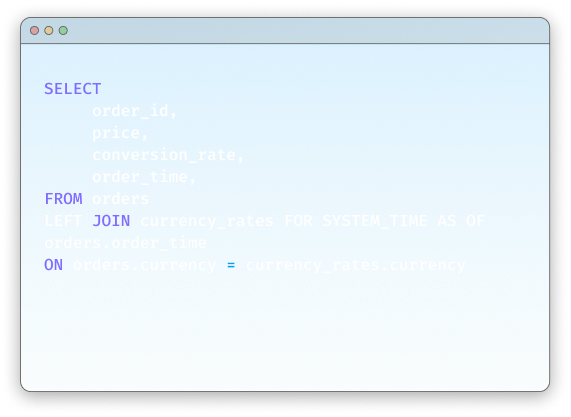

Crea pipelines de CDC con Apache Flink en Confluent

Más informaciónIntegración fluida entre Kafka y Flink

Evita integraciones tediosas con Confluent, que te permite tratar los datos como un producto reutilizable de primera clase y unir Apache Kafka® y Apache Flink® en un soo clic.

Los topics de Kafka aparecen automáticamente como tablas de Flink consultables con esquemas gestionados por Schema Registry, lo que permite reutilizar al instante los datos procesados.

Integración en un clic

Los topics y esquemas de Kafka siempre están sincronizados con Flink

Streaming cloud-native

El estándar cloud-native y totalmente gestionado para Apache Kafka®

Apache Flink® cloud-native

El estándar de código abierto para el procesamiento en streaming

Soporte nativo para la gestión de esquemas

Schema Registry proporciona un repositorio centralizado para gestionar y validar los esquemas de los datos en los mensajes de cada topic

Simplifica el procesamiento en streaming stateful

Aprovecha la potencia de Flink, el estándar de facto de la industria para el procesamiento en streaming complejo de eventos stateful.

Podrás usar los lenguajes estándar del sector (ANSI SQL, Python o Java) para procesar eventos complejos, agregar datos en tiempo real y realizar transformaciones stateful. Además, incluye soporte nativo para la tolerancia a fallos, semántica «exactly-once» y estrategias de marca de agua integradas.

Simplifica los requisitos de "exactly-once"

Garantiza la exactitud del procesamiento con Confluent Cloud

Desarrolla con ANSI SQL

Crea pipelines de procesamiento en streaming con SQL

Desarrolla con Python

Crea pipelines de procesamiento en streaming con la facilidad de Python

Desarrolla con Java

Crea aplicaciones de streaming con Java

Acelera tus lanzamientos con una plataforma totalmente gestionada

Dedica tus recursos a crear productos de datos —en lugar de a gestionar la infraestructura— con una experiencia serverless.

Gracias a su escalado automático y elástico, las tarifas basadas en el consumo y los límites de computación, el rendimiento y el coste están mucho mejor equilibrados. La flexibilidad de su interfaz de usuario (basada en navegador), la CLI y la extensión de VS Code, junto a las herramientas integradas de monitorización (como Stream Lineage, aceleran el desarrollo desde la fase de exploración hasta la de producción.

Convierte tu código en la máxima prioridad

Deja que Confluent Code gestione todo lo demás con nuestra oferta de Flink cloud-native y sin servidor

Espacios de trabajo de Flink SQL

La opción principal y basada en el navegador para usar SQL e interactuar con tus datos en Confluent Cloud

Confluent CLI

Gestiona declaraciones y grupos de cálculo en la CLI

Extensión de VS Code

Desarrolla sin distracciones con la extensión de VS Code

Desarrolla para un mundo centrado en IA

Desarrolla sistemas de IA/ML reactivos y en tiempo real, además de agentes impulsados por eventos.

Prepara los datos para la inferencia en tiempo real con funcionalidades de incrustación, previsión e inferencia que te ayudarán a integrar tus datos con modelos externos, LLMs, herramientas y marcos de trabajo. Simplifica tu pila tecnológica de IA: el foco ya ha pasado de la integración a la entrega de valor.

Embedding en tiempo real

Inserta vectores en tus datos dentro de pipelines de datos en streaming.

Pronósticos en tiempo real

Haz predicciones en tiempo real a medida que los eventos fluyen a través de tus pipelines en streaming

Inferencia en tiempo real

Ejecuta inferencias sobre eventos en tu stream

Llamadas de herramientas

Soporte nativo para la llamada de herramientas con MCP

«El procesamiento de streams es fundamental para identificar y proteger los riesgos de seguridad en tiempo real. Confluent nos permite usar Flink de forma totalmente gestionada, por lo que ahora podemos acceder, agregar y enriquecer datos de sensores IoT, cámaras inteligentes y análisis de wifi para tomar medidas sobre posibles amenazas en tiempo real, como la detección de intrusiones. Esto nos permite procesar los datos de los sensores en el momento que se producen los eventos y dar una respuesta más rápida a los incidentes de seguridad: todo ello, sin ninguna carga operativa adicional».

«El procesamiento de streams es fundamental para identificar y protegernos ante los riesgos de seguridad en tiempo real. Confluent nos permite usar Flink de forma totalmente gestionada, por lo que ahora podemos acceder, agregar y enriquecer datos de sensores IoT, cámaras inteligentes y análisis de wifi para tomar medidas sobre posibles amenazas en tiempo real, como la detección de intrusiones. Esto nos permite procesar los datos de los sensores en el momento que se producen los eventos y dar una respuesta más rápida a los incidentes de seguridad; todo ello, sin ninguna carga operativa adicional».

«Usamos Apache Flink para procesar nuestros datos antes de que lleguen a Snowflake y evitar costes adicionales innecesarios. Cuando hablamos de un almacén de datos, hay miles de millones de datos en una tabla, y procesarlos una vez han sido almacenados es muy caro. Ahora, en Flink, nuestros datos fluyen de forma continua. Los procesamos en ventanas temporales a medida que avanzan por el sistema. Puedes tener tus datos principales en un flujo que va a tu almacén de datos y, al mismo tiempo, agregar estos datos y enviarlos a otra plataforma de almacenamiento; es mucho más rentable y eficiente».

«Con Flink, ahora tenemos la oportunidad de desplazar el procesamiento a la izquierda y realizar muchas transformaciones y cálculos de nuestros datos antes de que lleguen a Snowflake. Esto optimizará nuestros costes de procesamiento de datos para aumentar la cantidad de datos que tenemos disponibles».

Los nuevos desarrolladores reciben 400 dólares en créditos para gastar durante los primeros 30 días. Puedes probarlo sin largas conversaciones con ningún equipo de ventas.

Estos son algunos ejemplos de lo que puedes conseguir con Confluent:

- Desarrollar con bibliotecas cliente para lenguajes como Java y Python, código de ejemplo, más de 120 conectores preconstruidos y una extensión de Visual Studio Code.

- Aprender con cursos disponibles a la carta, certificaciones y una comunidad mundial de expertos.

- Operar desde una interfaz de línea de comandos (CLI), con compatibilidad con IaC para Terraform y Pulumi, y observabilidad de OpenTelemetry.

Puedes registrarte desde la cuenta de tu marketplace en la nube preferido o crear una cuenta de Confluent gratis.

Confluent Cloud

Servicio cloud-native totalmente gestionado para Apache Kafka®

Formas de iniciar el procesamiento

Stream Processing With Confluent | FAQs

What is Apache Flink and why is it used for stream processing?

Apache Flink is the de facto open-source standard for stateful stream processing, designed to run computations over unbounded, continuous data streams. It's used for building real-time data pipelines and event-driven applications because it provides low-latency processing, high throughput, and exactly-once consistency guarantees, which are critical for trustworthy, mission-critical systems.

Do I need Apache Kafka to use Confluent's Flink service?

Yes. Confluent Cloud is designed as a unified data streaming platform where Apache Kafka and Apache Flink are seamlessly integrated. Data must be in a Confluent Cloud Kafka topic to be processed by Flink. This tight integration is a core benefit, as it removes the need for custom connectors and provides a single, governed source of truth for all real-time data. However, Confluent Platform enables use of Flink with a variety of sources outside Apache Kafka.

How is Confluent's serverless Flink different from open-source Apache Flink?

Confluent Cloud provides a fully managed, serverless Flink service that eliminates the significant operational complexity of deploying, scaling, and securing open-source Flink. While open-source Flink is a powerful engine, Confluent provides a complete data streaming platform around it, including zero-config integration with Kafka, an integrated Schema Registry, enterprise-grade security, and a usage-based pricing model, allowing teams to focus on logic, not infrastructure.

How can I control costs with Flink's usage-based pricing?

Confluent Cloud provides several tools for cost management. The pricing is pay-as-you-go, based on CFUs consumed per minute, so you only pay for what you use. You can set configurable, hard spending limits on your compute pools to prevent budget overruns and monitor usage through the Metrics API to optimize your queries for cost-efficiency.