Apache Kafka®️ 비용 절감 방법 및 최적의 비용 설계 안내 웨비나 | 자세히 알아보려면 지금 등록하세요

사용 사례 | CDC 파이프라인

Confluent에서 Apache Flink®를 사용한 CDC 파이프라인 구축

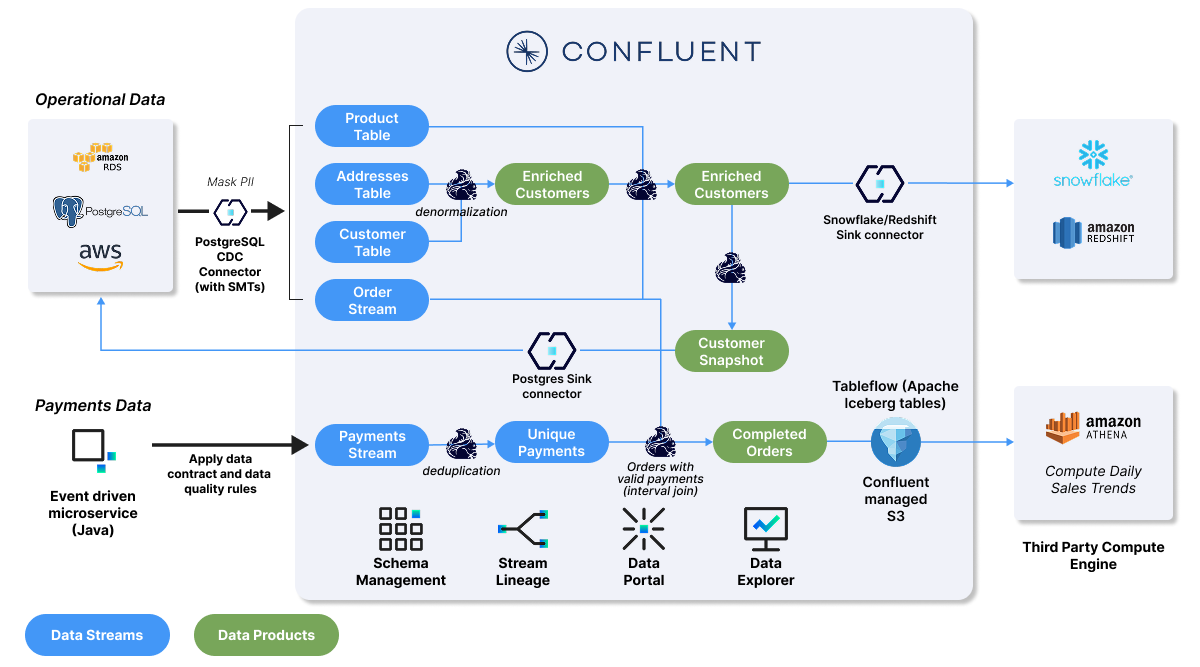

변경 데이터 캡처(CDC)는 관계형 ��데이터베이스 간에 데이터를 복제하는 데 사용되며, 데이터 동기화, 마이그레이션, 재해 복구와 같은 필수 백엔드 작업을 가능하게 합니다. 이제 스트림 처리를 통해 레거시 시스템과 최신 분산 시스템 전반에 통합된 최신 데이터로 이벤트 기반 애플리케이션과 신뢰할 수 있는 데이터 제품을 지원하는 CDC 파이프라인을 구축할 수 있습니다.

Confluent가 어떻게 Apache Kafka®와 Apache Flink®를 결합하여 스트리밍 CDC 파이프라인을 구축하고, 최신의 고품질 운영 데이터로 다운스트림 분석을 지원하는지 확인해 보세요.

오래된 데이터 기반의 의사 결정에서 벗어나 실시간 대응 체제로 전환합니다.

Go from making decisions on stale data to reacting in real time

처리 비용을 30% 절감합니다.

Reduce your processing costs by 30%

수동 장애 수정 작업 없이 신뢰할 수 있고 깨끗한 데이터를 제공합니다.

Deliver trusted, clean data without manual break-fix work

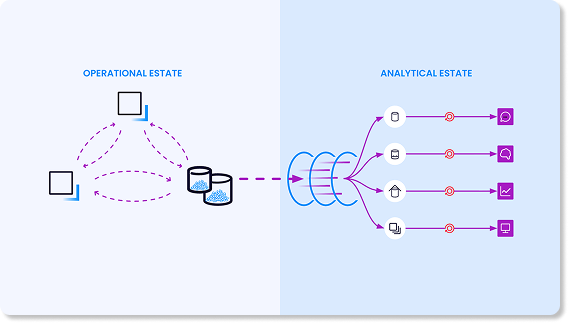

기존 CDC 아키텍처의<br>3가지 주요 과제

대부분의 조직은 이미 로그 기반 CDC를 사용하여 데이터베이스 변경 사항을 이벤트로 변환합니다.

- 일괄 처리로 인한 상당한 데이터 지연. 대부분의 조직은 이벤트 스트림 대신 일괄 처리에 의존하여 로그 데이터를 다운스트림에 구체화합니다. 이는 다음 일괄 처리 프로세스가 실행될 때까지 몇 시간 또는 며칠 동안 데이터 시스템이 동기화되지 않은 상태로 유지됨을 의미합니다.

- 중복 처리 비용. 포인트 투 포인트 통합을 구축 및 유지 관리하는 부담과 이러한 파이프라인 전반에서 발생하는 중복 처리로 인해 추가 비용이 발생합니다.

- 반복적인 수동 장애 수정 주기로 인한 신뢰 하락. 이 모든 파이프라인의 정확성을 유지하는 것은 시간이 많이 소요되며 휴먼 에러가 발생하기 쉽습니다. 또한 이러한 방식은 팀이 다른 다운스트림 consumers에게 영향을 미친 후에야 확인된 문제를 사후 대응적으로 수정하도록 강요합니다.

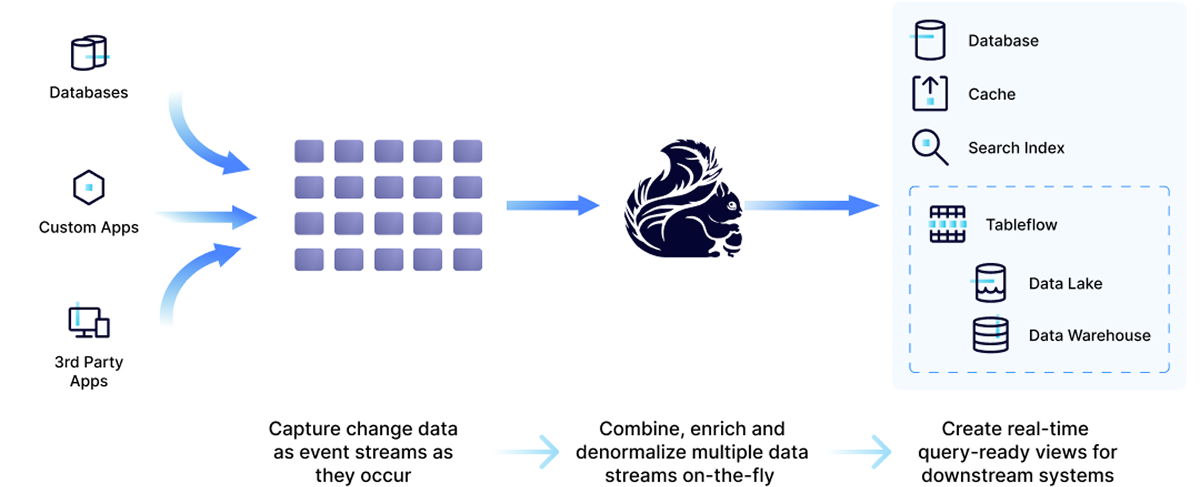

Kafka와 Flink로 CDC 파이프라인을 구축하면 CDC 워크로드와 일괄 처리 분석을 통합하고 처리 사일로를 제거할 수 있습니다. 일괄 처리를 기다리거나 중복 처리 비용을 감수하거나 취약한 파이프라인에 의존하는 대신, 이 아키텍처를 사용하면 다음을 수행할 수 있습니다.

- CDC 데이터를 이벤트 스트림으로 캡처

- Flink를 사용하여 해당 스트림을 실시간으로 처리

- 운영 및 분석 환경 전반에서 CDC 스트림을 즉시 구체화

획기적으로 절감된 비용으로 데이터 가치 극대화

서버리스 Apache Flink®를 Confluent 데이터 스트리밍 플랫폼에서 사용하면 데이터 수집 전 단계로 처리를 Shift Left 하여 지연 시간, 데이터 이동성, 비용 효율성을 개선할 수 있습니다.

- 데이터 강화: 추가적인 컨텍스트로 데이터를 강화하여 정확성을 향상시킵니다.

- 데이터 재사용성: 애플리케이션 간에 일관된 데이터 스트림을 공유합니다.

- 어디서나 실시간으로: 저지연 애플리케이션이 이벤트에 즉시 반응하도록 지원합니다.

- 비용 절감: 리소스 사용을 최적화하고 중복 처리를 줄입니다.

앱 개발(AppDev) 팀은 적시 조치를 가능하게 하는 데이터 파이프라인을 구축할 수 있습니다.

분석, 실시간 검색 인덱스 구축, ML 파이프라인, SIEM 최적화를 위한 Shift-Left 데이터 웨어하우스 및 데이터 레이크 수집이 필요한 경우.

분석 팀은 계산, 상태 업데이트, 외부 작업을 트리거하여 이벤트 기반 애플리케이션에 공급할 데이터를 준비하고 가공할 수 있습니다.

여기에는 생성형 AI 솔루션, 사기 탐지, 실시간 경고 및 알림, 마케팅 개인화 등을 위해 구축된 애플리케이션이 포함됩니다.

Confluent 스트림 처리로 CDC 파이프라인을 구축하는 3단계

Confluent를 사용하면 분석 환경에서 CDC 스트림을 구체화하기 전에 처리할 수 있습니다. Flink SQL을 사용하여 Kafka topics에서 캡처한 변경 데이터를 간편하게 필터링, 조인, 강화합니다. 그 후 운영 및 분석 환경 모두에서 데이터 스트림을 구체화합니다.

스트리밍 CDC 데모 및 사례 연구

Confluent 고객들은 Flink를 사용하여 데이터 동기화 및 재해 복구와 같은 기존 CDC 사용 사례를 개선하고 새로운 실시간 기능을 확보하고 있습니다.

GitHub 리포지토리를 방문하여 Customer 360 및 제품 판매 분석, 또는 판매 추세 분석을 위한 실시간 분석 구현 방법을 알아보세요.

선택 가능한 2가지 실습이 있습니다.

"CDC를 채택함으로써 실시간 데이터의 강력한 힘을 발휘하고, 궁극적으로 일괄 처리 데이터 워크로드에서 스트림 처리로 전환할 수 있었습니다."

"Flink를 사용하여 이제 Shift Left를 통해 데이터가 Snowflake에 도달하기 전에 초기 데이터 변환 및 계산을 대폭 수행할 수 있는 기회를 얻게 되었습니다. 이를 통해 데이터 처리 비용을 최적화하고 사용 가능한 데이터의 양을 늘릴 수 있습니다."

"Confluent를 사용하면 10분마다 일괄로 데이터를 가져오는 대신, 실시간 데이터 수집을 위한 CDC 파이프라인을 쉽게 구축하여 사기를 신속하게 탐지할 수 있습니다."

"가장 어려웠던 점은 CDC와 스트리밍 프로세스를 개발할 내부 리소스가 부족했다는 것이었습니다. 이제 우리는 CDC 시스템을 쉽게 구축할 수 있으며... 개발팀은 스트리밍 프로세스를 개발하는 동안 업무 부하를 줄일 수 있었습니다."

"Confluent Cloud를 통해 이제 운영 데이터를 필요로 하는 모든 팀에 실시간으로 제공할 수 있습니다. 이는 정말 강력하며 운영 부담을 크게 줄여줍니다."

Flink로 CDC 데이터를 실시간 처리할 준비가 되셨나요? Confluent로 시작하여 어떤 환경에도 대응 가능한 스트림 처리 아키텍처를 구현하세요.

AWS, Google Cloud, Microsoft Azure에서 이용 가능한 Confluent Cloud for Apache Flink®를 사용해 보세요. 서버리스 및 클라우드 네이티브의 비용 효율성과 간단함을 갖춘 Kafka + Flink 기반 애플리케이션을 구축할 수 있습니다.

또한 Apache Flink®용 Confluent Platform을 사용하면 기존 Flink 워크로드를 자체 관리형 데이터 스트리밍 플랫폼으로 가져와 온프레미스 또는 프라이빗 클라우드에 즉시 배포할 수 있습니다.

Confluent Cloud

Apache Kafka®를 위한<br />클라우드-네이티브 서비스

Streaming CDC With Flink | FAQs

How does a streaming approach improve on batch ELT/ETL pipelines?

A streaming approach allows you to "shift left," processing and governing data closer to the source. Instead of running separate, costly ELT jobs in multiple downstream systems, you process the data once in-stream with Flink to create a single, reusable, high-quality data product. This improves data quality, reduces overall processing costs and risks, and gets trustworthy data to your teams faster.

Why use Apache Flink® for processing real-time CDC Data?

Apache Flink® is the de facto standard for stateful stream processing, designed for high-performance, low-latency workloads—making it ideal for CDC. Its ability to handle stateful computations allows it to accurately interpret streams of inserts, updates, and deletes to maintain a correct, materialized view of data over time. Confluent offers a fully managed, serverless Flink service that removes the operational burden of self-management.

How do you handle data consistency and quality in real-time CDC pipeline?

Data consistency is maintained by processing CDC events in-flight to filter duplicates, join streams for enrichment, and aggregate data correctly before it reaches any downstream system. Confluent's platform integrates Flink with Stream Governance, including Schema Registry, to define and enforce universal data standards, ensuring data compatibility, quality, and lineage tracking across your organization.

How does Confluent Cloud handle changes to the source database schema?

When your CDC pipeline is integrated with Confluent Schema Registry, it can automatically and safely handle schema evolution. This ensures that changes to the source table structure—like adding or removing columns—do not break downstream applications or data integrity. The platform manages schema compatibility, allowing your data streams to evolve seamlessly.

What are the main benefits of using a Fully managed service for Apache Flink® like Confluent Cloud?

A fully managed service eliminates the significant operational complexity, steep learning curve, and high in-house support costs associated with self-managing Apache Flink®. With Confluent, you get a serverless experience with elastic scalability, automated updates, and pay-as-you-go pricing, allowing your developers to focus on building applications rather than managing infrastructure. In addition, native integration between Apache Kafka® and Apache Flink® and pre-built connectors allow teams to build and scale fast.

How does Confluent Cloud simplify processing Debezium CDC events?

Confluent Cloud provides first-class support for Debezium, an open source distributed platform for change data capture. Pre-built connectors can automatically interpret the complex structure of Debezium CDC event streams, simplifying the process of integrating with Kafka and Flink.